wendaoit / fangwangye404 Goto Github PK

View Code? Open in Web Editor NEW备份我平时博客参考的网址,防止🛸🛸🛸

License: Boost Software License 1.0

备份我平时博客参考的网址,防止🛸🛸🛸

License: Boost Software License 1.0

在百度知道上发现了一个绝对很 nice 的回答

对 epoll 的解释很清晰到位,这里转载下

如侵立删

作者为(dsuwlzon )

原文如下 (本文为了方便阅读重新进行了排版)

假设你在大学中读书,要等待一个朋友来访,而这个朋友只知道你在 A 号楼,但是不知道你具体住在哪里,于是你们约好了在 A 号楼门口见面.

如果你使用的阻塞 IO 模型来处理这个问题,那么你就只能一直守候在 A 号楼门口等待朋友的到来,在这段时间里你不能做别的事情,不难知道,这种方式的效率是低下的.

进一步解释 select 和 epoll 模型的差异.

select 版大妈做的是如下的事情:比如同学甲的朋友来了,select 版大妈比较笨,她带着朋友挨个房间进行查询谁是同学甲,你等的朋友来了,于是在实际的代码中,select 版大妈做的是以下的事情:

int n = select(&readset,NULL,NULL,100);

for (int i = 0; n > 0; ++i) {

if (FD_ISSET(fdarray[i], &readset)) {

do_something(fdarray[i]); --n;

}

}

epoll 版大妈就比较先进了,她记下了同学甲的信息,比如说他的房间号,那么等同学甲的朋友到来时,只需要告诉该朋友同学甲在哪个房间即可,不用自己亲自带着人满大楼的找人了。于是 epoll 版大妈做的事情可以用如下的代码表示:

n = epoll_wait(epfd,events,20,500);

for(i=0;i<n;++i) { do_something(events[n]);

}

在 epoll 中,关键的数据结构 epoll_event 定义如下:

typedef union epoll_data {

void *ptr;

int fd;

__uint32_t u32;

__uint64_t u64;

}epoll_data_t;

struct epoll_event {

__uint32_t events; /* Epoll events */

epoll_data_t data;/* User data variable */

};

可以看到,epoll_data 是一个 union 结构体,它就是 epoll 版大妈用于保存同学信息的结构体,它可以保存很多类型的信息:

fd, 指针,等等。有了这个结构体,epoll 大妈可以不用吹灰之力就可以定位到同学甲.

别小看了这些效率的提高,在一个大规模并发的服务器中,轮询 IO 是最耗时间的操作之一。再回到那个例子中,如果每到来一个朋友楼管大妈都要全楼的查询同学,那么处理的效率必然就低下了,过不久楼底就有不少的人了.

对比最早给出的阻塞 IO 的处理模型,可以看到采用了多路复用 IO 之后,程序可以自由的进行自己除了 IO 操作之外的工作,只有到 IO 状态发生变化的时候由多路复用 IO 进行通知,然后再采取相应的操作,而不用一直阻塞等待 IO 状态发生变化了.

从上面的分析也可以看出,epoll 比 select 的提高实际上是一个用空间换时间**的具体应用.

大家都明白 epoll 是一种 IO 多路复用技术,可以非常高效的处理数以百万计的 socket 句柄,比起以前的 select 和 poll 效率高大发了。

我们用起 epoll 来都感觉挺爽,确实快,那么,它到底为什么可以高速处理这么多并发连接呢?

先简单回顾下如何使用 C 库封装的 3 个 epoll 系统调用吧。

int epoll_create(int size);

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

int epoll_wait(int epfd, struct epoll_event *events,int maxevents, int timeout);

使用起来很清晰,首先要调用 epoll_create 建立一个 epoll 对象。参数 size 是内核保证能够正确处理的最大句柄数,多于这个最大数时内核可不保证效果。

epoll_ctl 可以操作上面建立的 epoll,例如,将刚建立的 socket 加入到 epoll 中让其监控,或者把 epoll 正在监控的某个 socket 句柄移出 epoll,不再监控它等等。

epoll_wait 在调用时,在给定的 timeout 时间内,当在监控的所有句柄中有事件发生时,就返回用户态的进程。

从上面的调用方式就可以看到 epoll 比 select/poll 的优越之处:

因为后者每次调用时都要传递你所要监控的所有 socket 给 select/poll 系统调用,这意味着需要将用户态的 socket 列表 copy 到内核态,如果以万计的句柄会导致每次都要 copy 几十几百 KB 的内存到内核态,非常低效。

而我们调用 epoll_wait 时就相当于以往调用 select/poll,但是这时却不用传递 socket 句柄给内核,因为内核已经在 epoll_ctl 中拿到了要监控的句柄列表。

所以,实际上在你调用 epoll_create 后,内核就已经在内核态开始准备帮你存储要监控的句柄了,每次调用 epoll_ctl 只是在往内核的数据结构里塞入新的 socket 句柄。

在内核里,一切皆文件。所以,epoll 向内核注册了一个文件系统,用于存储上述的被监控 socket。

当你调用 epoll_create 时,就会在这个虚拟的 epoll 文件系统里创建一个 file 结点。当然这个 file 不是普通文件,它只服务于 epoll。epoll 在被内核初始化时(操作系统启动),同时会开辟出 epoll 自己的内核高速 cache 区,用于安置每一个我们想监控的 socket,这些 socket 会以红黑树的形式保存在内核 cache 里,以支持快速的查找、插入、删除。

这个内核高速 cache 区,就是建立连续的物理内存页,然后在之上建立 slab 层,简单的说,就是物理上分配好你想要的 size 的内存对象,每次使用时都是使用空闲的已分配好的对象。

static int __init eventpoll_init(void) {

... ...

/* Allocates slab cache used to allocate "struct epitem" items */

epi_cache = kmem_cache_create("eventpoll_epi", sizeof(struct epitem),0,SLAB_HWCACHE_ALIGN| EPI_SLAB_DEBUG|SLAB_PANIC, NULL, NULL);

/* Allocates slab cache used to allocate "struct eppoll_entry" */

pwq_cache = kmem_cache_create("eventpoll_pwq", sizeof(struct eppoll_entry), 0, EPI_SLAB_DEBUG|SLAB_PANIC, NULL, NULL);

... ...

epoll 的高效就在于,当我们调用 epoll_ctl 往里塞入百万个句柄时,epoll_wait 仍然可以飞快的返回,并有效的将发生事件的句柄给我们用户。

这是由于我们在调用 epoll_create 时,内核除了帮我们在 epoll 文件系统里建了个 file 结点,在内核 cache 里建了个红黑树用于存储以后 epoll_ctl 传来的 socket 外,还会再建立一个 list 链表,用于存储准备就绪的事件,当 epoll_wait 调用时,仅仅观察这个 list 链表里有没有数据即可。有数据就返回,没有数据就 sleep,等到 timeout 时间到后即使链表没数据也返回。所以,epoll_wait 非常高效。

那么,这个准备就绪 list 链表是怎么维护的呢?当我们执行 epoll_ctl 时,除了把 socket 放到 epoll 文件系统里 file 对象对应的红黑树上之外,还会给内核中断处理程序注册一个回调函数,告诉内核,如果这个句柄的中断到了,就把它放到准备就绪 list 链表里。

所以,当一个 socket 上有数据到了,内核在把网卡上的数据 copy 到内核中后就来把 socket 插入到准备就绪链表里了。

如此,一颗红黑树,一张准备就绪句柄链表,少量的内核 cache,就帮我们解决了大并发下的 socket 处理问题。

执行 epoll_create 时,创建了红黑树和就绪链表,执行 epoll_ctl 时,如果增加 socket 句柄,则检查在红黑树中是否存在,存在立即返回,不存在则添加到树干上,然后向内核注册回调函数,用于当中断事件来临时向准备就绪链表中插入数据。执行 epoll_wait 时立刻返回准备就绪链表里的数据即可。

最后看看 epoll 独有的两种模式 LT 和 ET。无论是 LT 和 ET 模式,都适用于以上所说的流程。

区别是,LT 模式下,只要一个句柄上的事件一次没有处理完,会在以后调用 epoll_wait 时次次返回这个句柄,而 ET 模式仅在第一次返回。

这件事怎么做到的呢?当一个 socket 句柄上有事件时,内核会把该句柄插入上面所说的准备就绪 list 链表,这时我们调用 epoll_wait,会把准备就绪的 socket 拷贝到用户态内存,然后清空准备就绪 list 链表,最后,epoll_wait 干了件事,就是检查这些 socket,如果不是 ET 模式(就是 LT 模式的句柄了),并且这些 socket 上确实有未处理的事件时,又把该句柄放回到刚刚清空的准备就绪链表了。

所以,非 ET 的句柄,只要它上面还有事件,epoll_wait 每次都会返回。而 ET 模式的句柄,除非有新中断到,即使 socket 上的事件没有处理完,也是不会次次从 epoll_wait 返回的。

Linux 提供了 select、poll、epoll 接口来实现 IO 复用,三者的原型如下所示,本文从参数、实现、性能等方面对三者进行对比。

int select(int nfds, fd_set *readfds, fd_set *writefds, fd_set *exceptfds, struct timeval *timeout);

int poll(struct pollfd *fds, nfds_t nfds, int timeout);

int epoll_wait(int epfd, struct epoll_event *events, int maxevents, int timeout);

select、poll、epoll_wait 参数及实现对比

本系列主要分五部分:

1.《WEB 请求处理一:浏览器请求发起处理》:分析用户在浏览器中输入 URL 地址,浏览器如何找到服务器地址的过程,并发起请求;

2.《WEB 请求处理二:Nginx 请求反向代理》:分析请求在达反向代理服务器内部处理过程;

3.《WEB 请求处理三:Servlet 容器请求处理》:分析请求在 Servlet 容器内部处理过程,并找到目标应用程序;

4.《WEB 请求处理四:WEB MVC 框架请求处理》:分析请求在应用程序内部,开源 MVC 框架的处理过程;

5.《WEB 请求处理五:浏览器请求响应处理》:分析请求在服务器端处理完成后,浏览器渲染响应页面过程;

为直观明了,先上一张图,红色部分为本章所述模块:

本章所述模块

我们先了解下 B/S 网络架构是什么?B/S 网络架构从前端到后端都得到了简化,都基于统一的应用层协议 HTTP 来交互数据,HTTP 协议采用无状态的短链接的通信方式,通常情况下,一次请求就完成了一次数据交互,通常也对应一个业务逻辑,然后这次通信连接就断开了。采用这种方式是为了能够同时服务更多的用户,因为当前互联网应用每天都会处理上亿的用户请求,不可能每个用户访问一次后就一直保持住这个连接。

当一个用户在浏览器里输入 www.google.com 这个 URL 时,将会发生如下操作:

- 首先,浏览器会请求 DNS 把这个域名解析成对应的 IP 地址;

- 然后,根据这个 IP 地址在互联网上找到对应的服务器,建立 Socket 连接,向这个服务器发起一个 HTTP Get 请求,由这个服务器决定返回默认的数据资源给访问的用户;

- 在服务器端实际上还有复杂的业务逻辑:服务器可能有多台,到底指定哪台服务器处理请求,这需要一个负载均衡设备来平均分配所有用户的请求;

- 还有请求的数据是存储在分布式缓存里还是一个静态文件中,或是在数据库里;

- 当数据返回浏览器时,浏览器解析数据发现还有一些静态资源(如:css,js 或者图片)时又会发起另外的 HTTP 请求,而这些请求可能会在 CDN 上,那么 CDN 服务器又会处理这个用户的请求;

以上具体流程,如图所示:

以上具体流程,如图所示

不管网络架构如何变化,但是始终有一些固定不变的原则需要遵守:

- 互联网上所有资源都要用一个 URL 来表示。URL 就是统一资源定位符;

- 必须基于 HTTP 协议与服务端交互;

- 数据展示必须在浏览器中进行;

B/S 网络架构的核心是 HTTP 协议,最重要的就是要熟悉 HTTP 协议中的 HTTP Header,HTTP Header 控制着互联网上成千上万的用户的数据传输。最关键的是,它控制着用户浏览器的渲染行为和服务器的执行逻辑。

常见的 HTTP 请求头:

常见的 HTTP 请求头

常见的 HTTP 响应头:

常见的 HTTP 响应头

常见的 HTTP 状态码:

常见的 HTTP 状态码

当我们使用 Ctrl+F5 组合键刷新一个页面时,首先是在浏览器端,会直接向目标 URL 发送请求,而不会使用浏览器缓存的数据;其次即使请求发送到服务端,也有可能访问到的是缓存的数据。所以在 HTTP 的请求头中会增加一些请求头,它告诉服务端我们要获取最新的数据而非缓存。最重要的是在请求 Head 中增加了两个请求项 Pragma:no-cache 和 Cache-Control:no-cache。

这个 HTTP Head 字段**用于指定所有缓存机制在整个请求 / 响应链中必须服从的指令,如果知道该页面是否为缓存,不仅可以控制浏览器,还可以控制和 HTTP 协议相关的缓存或代理服务器**。

Cache-Control/Pragma 字段的可选值:

Cache-Control/Pragma 字段的可选值

Cache-Control 请求字段被各个浏览器支持的较好,而且它的优先级也比较高,它和其他一些请求字段(如 Expires)同时出现时,Cache-Control 会覆盖其他字段。

Pragma 字段的作用和 Cache-Control 有点类似,它也是在 HTTP 头中包含一个特殊的指令,使相关的服务器来遵守,最常用的就是 Pragma:no-cache,它和 Cache-Control:no-cache 的作用是一样的。

Expires 通常的使用格式是 Expires:Sat,25 Feb 2012 12:22:17 GMT,后面跟着一个日期和时间,超过这个值后,缓存的内容将失效,也就是**浏览器在发出请求之前检查这个页面的这个字段,看该页面是否已经过期了,过期了将重新向服务器发起请求**。

Last-Modified 字段一般用于表示一个服务器上的字段的最后修改时间,资源可以是静态(静态内容自动加上 Last-Modified)或者动态的内容(如 Servlet 提供了一个 getLastModified 方法用于检查某个动态内容是否已经更新),通过这个最后修改时间可以判断当前请求的资源是否是最新的。

一般服务器端在响应头中返回一个 Last-Modified 字段,告诉浏览器这个页面的最后修改时间,如:Sat,25 Feb 2012 12:55:04 GMT,浏览器再次请求时在请求头中增加一个 If-Modified-Since:Sat,25 Feb 2012 12:55:04 GMT 字段,询问当前缓存的页面是否是最新的,如果是最新的就会返回 304 状态码,告诉浏览器是最新的,服务器也不会传输新的数据。

与 Last-Modified 字段有类似功能的还有一个 Etag 字段,这个字段的作用是让服务端给每个页面分配一个唯一编号,然后通过这个编号来区分当前这个页面是否是最新的。这种方式比使用 Last-Modified 更加灵活,但是在后端的 Web 服务器有多台时比较难处理,因为每个 Web 服务器都要记住网站的所有资源编号,否则浏览器返回这个编号就没有意义了。

对于正常的上网过程,系统其实是这样做的:

浏览器本身是一个客户端,当你输入 URL 的时候,

首先浏览器会去请求 DNS 服务器,通过 DNS 获取相应的域名对应的 IP,然后通过 IP 地址找到 IP 对应的服务器后,要求建立 TCP 连接,等浏览器发送完 HTTP Request(请求)包后,服务器接收到请求包之后才开始处理请求包,服务器调用自身服务,返回 HTTP Response(响应)包;客户端收到来自服务器的响应后开始渲染这个 Response 包里的主体(body),等收到全部的内容随后断开与该服务器之间的 TCP 连接。

Web 请求的工作原理

Web 请求的工作原理可以简单地归纳为:

- 浏览器通过 DNS 域名解析到服务器 IP;

- 客户机通过 TCP/IP 协议建立到服务器的 TCP 连接;

- 客户端向服务器发送 HTTP 协议请求包,请求服务器里的资源文档;

- 服务器向客户机发送 HTTP 协议应答包,如果请求的资源包含有动态语言的内容,那么服务器会调用动态语言的解释引擎负责处理 “动态内容”,并将处理得到的数据返回给客户端;

- 客户机与服务器断开。由客户端解释 HTML 文档,在客户端屏幕上渲染图形结果;

一个简单的 HTTP 事务就是这样实现的,看起来很复杂,原理其实是挺简单的。需要注意的是客户机与服务器之间的通信是非持久连接的,也就是当服务器发送了应答后就与客户机断开连接,等待下一次请求。

当用户在浏览器中输入域名,如:www.google.com,并按下回车后,DNS 解析过程大体如下:

DNS 解析过程

浏览器会首先搜索浏览器自身的 DNS 缓存(缓存时间比较短,大概只有 1 分钟,且只能容纳 1000 条缓存),看自身的缓存中是否有 www.google.com 对应的条目,而且没有过期,如果有且没有过期则解析到此结束。

浏览器缓存域名也是有限制的,不仅浏览器缓存大小有限制,而且缓存的时间也有限制,通常情况下为几分钟到几小时不等,域名被缓存的时间限制可以通过 TTL 属性来设置。这个缓存时间太长和太短都不好,如果缓存时间太长,一旦域名被解析到的 IP 有变化,会导致被客户端缓存的域名无法解析到变化后的 IP 地址,以致该域名不能正常解析,这段时间内有可能会有一部分用户无法访问网站。如果时间设置太短,会导致用户每次访问网站都要重新解析一次域名。

注:我们怎么查看 Chrome 自身的缓存?可以使用 chrome://net-internals/#dns 来进行查看

查看 Chrome 自身的 DNS 缓存

如果浏览器自身的缓存里面没有找到对应的条目,其实操作系统也会有一个域名解析的过程,那么 Chrome 会首先搜索操作系统自身的 DNS 缓存中是否有这个域名对应的 DNS 解析结果,如果找到且没有过期则停止搜索解析到此结束。

其次在 Linux 中可以通过 / etc/hosts 文件来设置,你可以将任何域名解析到任何能够访问的 IP 地址。如果你在这里指定了一个域名对应的 IP 地址,那么浏览器会首先使用这个 IP 地址。当解析到这个配置文件中的某个域名时,操作系统会在缓存中缓存这个解析结果,缓存的时间同样是受这个域名的失效时间和缓存的空间大小控制的。

如果在 hosts 文件中也没有找到对应的条目,浏览器就会发起一个 DNS 的系统调用,就会向本地配置的首选 DNS 服务器(LDNS 一般是电信运营商提供的,也可以使用像 Google 提供的 DNS 服务器)发起域名解析请求(通过的是 UDP 协议向 DNS 的 53 端口发起请求,这个请求是递归的请求,也就是运营商的 DNS 服务器必须得提供给我们该域名的 IP 地址)。

在我们的网络配置中都会有 “DNS 服务器地址” 这一项,这个地址就用于解决前面所说的如果两个过程无法解析时要怎么办,操作系统会把这个域名发送给这里设置的 LDNS,也就是本地区的域名服务器。这个 DNS 通常都提供给你本地互联网接入的一个 DNS 解析服务,例如你是在学校接入互联网,那么你的 DNS 服务器肯定在你的学校,如果你是在一个小区接入互联网的,那这个 DNS 就是提供给你接入互联网的应用提供商,即电信或者联通,也就是通常所说的 SPA,那么这个 DNS 通常也会在你所在城市的某个角落,通常不会很远。这个专门的域名解析服务器性能都会很好,它们一般都会缓存域名解析结果,当然缓存时间是受域名的失效时间控制的,一般缓存空间不是影响域名失效的主要因素。大约 80% 的域名解析都到这里就已经完成了,所以 LDNS 主要承担了域名的解析工作。

运营商的 DNS 服务器首先查找自身的缓存,找到对应的条目,且没有过期,则解析成功。

运营商的 DNS 服务器

如果 LDNS 没有找到对应的条目,则由运营商的 DNS 代我们的浏览器发起迭代 DNS 解析请求。它首先是会找根域的 DNS 的 IP 地址(这个 DNS 服务器都内置 13 台根域的 DNS 的 IP 地址),找到根域的 DNS 地址,就会向其发起请求(请问 www.google.com 这个域名的 IP 地址是多少啊?)。

根域发现这是一个顶级域 com 域的一个域名,于是就告诉运营商的 DNS 我不知道这个域名的 IP 地址,但是我知道 com 域的 IP 地址,你去找它去。

于是运营商的 DNS 就得到了 com 域的 IP 地址,又向 com 域的 IP 地址发起了请求(请问 www.google.com 这个域名的 IP 地址是多少?),com 域这台服务器告诉运营商的 DNS 我不知道 www.google.com 这个域名的 IP 地址,但是我知道 google.com 这个域的 DNS 地址,你去找它去。

于是运营商的 DNS 又向 google.com 这个域名的 DNS 地址(这个一般就是由域名注册商提供的,像万网,新网等)发起请求(请问 www.google.com 这个域名的 IP 地址是多少?),这个时候 google.com 域的 DNS 服务器一查,果真在我这里,于是就把找到的结果发送给运营商的 DNS 服务器,这个时候运营商的 DNS 服务器就拿到了 www.google.com 这个域名对应的 IP 地址。

通过上面的步骤,我们最后获取的是 IP 地址,也就是浏览器最后发起请求的时候是基于 IP 来和服务器做信息交互的。在实际的 DNS 解析过程中,可能还不止这 10 个步骤,如 Name Server 也可能有多级,或者有一个 GTM 来负载均衡控制,这都有可能会影响域名解析的过程。根据以上解析流程,DNS 解析整个过程,分为:递归查询过程和迭代查询过程。如图所示:

DNS 解析整个过程

所谓 递归查询过程 就是 “查询的递交者” 更替, 而 迭代查询过程 则是 “查询的递交者” 不变。

举个例子来说,你想知道某个一起上法律课的女孩的电话,并且你偷偷拍了她的照片,回到寝室告诉一个很仗义的哥们儿,这个哥们儿二话没说,拍着胸脯告诉你,甭急,我替你查 (

此处完成了一次递归查询,即,问询者的角色更替)。然后他拿着照片问了学院大四学长,学长告诉他,这姑娘是 xx 系的;然后这哥们儿马不停蹄又问了 xx 系的办公室主任助理同学,助理同学说是 xx 系 yy 班的,然后很仗义的哥们儿去 xx 系 yy 班的班长那里取到了该女孩儿电话。(此处完成若干次迭代查询,即,问询者角色不变,但反复更替问询对象) 最后,他把号码交到了你手里。完成整个查询过程。

在 Linux 系统中还可以**使用 dig 命名来查询 DNS 的解析过程,如下所示:dig +cmd +trace www.google.com**

使用 dig 命名来查询 DNS 的解析过程

上面清楚地显示了整个域名是如何发起和解析的,从根域名 (.) 到 gTLD Server(.com.)再到 Name Server (google.com.)的整个过程都显示出来了。还可以看出 DNS 的服务器有多个备份,可以从任何一台查询到解析结果。

我们知道 DNS 域名解析后会缓存解析结果,其中主要在两个地方缓存结果,一个是 Local DNS Server,另外一个是用户的本地机器。这两个缓存都是 TTL 值和本机缓存大小控制的,但是最大缓存时间是 TTL 值,基本上 Local DNS Server 的缓存时间就是 TTL 控制的,很难人工介入,但是我们的本机缓存可以通过如下方式清除。

在 Linux 下可以通过 /etc/init.d/nscd restart 来清除 DNS 缓存。如下:

在 Linux 下清除 DNS 缓存

JVM 缓存 DNS 解析结果:

在 Java 应用中 JVM 也会缓存 DNS 的解析结果,这个缓存是在 InetAddress 类中完成的,而且这个缓存时间还比较特殊,它有两种缓存策略:一种是正确解析结果缓存,另一种是失败的解析结果缓存。这两个缓存时间由两个配置项控制,配置项是在 % JAVA_ HOME%\lib\security\java.security 文件中配置的。两个配置项分别是 networkaddress.cache.ttl 和 networkaddress.cache.negative.ttl,它们的默认值分别是 - 1(永不失效)和 10(缓存 10 秒)。

要修改这两个值同样有几种方式,分别是:直接修改 java.security 文件中的默认值、在 Java 的启动参数中增加 - Dsun.net.inetaddr.ttl=xxx 来修改默认值、通过 InetAddress 类动态修改。

在这里还要特别强调一下,如果我们需要用 InetAddress 类解析域名时,一定要是单例模式,不然会有严重的性能问题,如果每次都创建 InetAddress 实例,每次都要进行一次完整的域名解析,非常耗时,这点要特别注意。

如将 item.taobao.com 指定到 115.238.23.241,将 switch.taobao.com 指定到 121.14.24.241。A 记录可以将多个域名解析到一个 IP 地址,但是不能将一个域名解析到多个 IP 地址。

如 taobao.com 域名的 A 记录 IP 地址是 115.238.25.245,如果 MX 记录设置为 115.238.25.246,是 [email protected] 的邮件路由,DNS 会将邮件发送到 115.238.25.246 所在的服务器,而正常通过 Web 请求的话仍然解析到 A 记录的 IP 地址。

如将 taobao.com 解析到 xulingbo.net,将 srcfan.com 也解析到 xulingbo.net,其中 xulingbo.net 分别是 taobao.com 和 srcfan.com 的别名。前面的跟踪域名解析中的 “www.taobao.com. 1542 IN CNAME www.gslb.taobao.com” 就是 CNAME 解析。

前面的 “google.com. 172800 IN NS ns4.google.com.” 就是 NS 解析。

如可以为 google.com 设置 TXT 记录为 “谷歌 | **” 这样的说明。

Linux 虚拟机测试,使用命令 wget www.linux178.com 来请求,发现直接使用 chrome 浏览器请求时,干扰请求比较多,所以就使用 wget 命令来请求,不过使用 wget 命令只能把 index.html 请求回来,并不会对 index.html 中包含的静态资源(js、css 等文件)进行请求。

抓包截图如下:

抓包截图

1 号包,这个是那台虚拟机在广播,要获取 192.168.100.254(也就是网关)的 MAC 地址,

因为局域网的通信靠的是 MAC 地址,它为什么需要跟网关进行通信是因为我们的 DNS 服务器 IP 是外围 IP,要出去必须要依靠网关帮我们出去才行。2 号包,这个是网关收到了虚拟机的广播之后,

回应给虚拟机的回应,告诉虚拟机自己的 MAC 地址,于是客户端找到了路由出口。3 号包,这个包是 wget 命令向系统配置的 DNS 服务器提出域名解析请求(准确的说应该是 wget 发起了一个 DNS 解析的系统调用),请求的域名 www.linux178.com,

期望得到的是 IP6 的地址(AAAA 代表的是 IPv6 地址)。4 号包,这个 DNS 服务器给系统的响应,很显然目前使用 IPv6 的还是极少数,所以得不到 AAAA 记录的。

5&6 号包,这个还是请求解析 IPv6 地址,但是 www.linux178.com.leo.com 这个主机名是不存在的,所以得到结果就是 no such name。

7 号包,这个才是请求的域名对应的 IPv4 地址(A 记录)。

8 号包,

DNS 服务器不管是从缓存里面,还是进行迭代查询最终得到了域名的 IP 地址,响应给了系统,系统再给了 wget 命令,wget 于是得到了 www.linux178.com 的 IP 地址,这里也可以**看出客户端和本地的 DNS 服务器是递归的查询(也就是服务器必须给客户端一个结果)这就可以开始下一步了**,进行 TCP 的三次握手。

拿到域名对应的 IP 地址之后,**User-Agent(一般是指浏览器)会以一个随机端口(1024 < 端口 < 65535)向服务器的 WEB 程序(常用的有 httpd,nginx 等)80 端口发起 TCP 的连接请求。**这个连接请求(原始的 http 请求经过 TCP/IP4 层模型的层层封包)到达服务器端后(这中间通过各种路由设备,局域网内除外),进入到网卡,然后是进入到内核的 TCP/IP 协议栈(用于识别该连接请求,解封包,一层一层的剥开),还有可能要经过 Netfilter 防火墙(属于内核的模块)的过滤,最终到达 WEB 程序,最终建立了 TCP/IP 的连接。

如下图所示:

03174517_saG0.png

- Client 首先发送一个连接试探,ACK=0 表示确认号无效,SYN = 1 表示这是一个连接请求或连接接受报文,同时表示这个数据报不能携带数据,seq = x 表示 Client 自己的初始序号(seq = 0 就代表这是第 0 号包),这时候 Client 进入 syn_sent 状态,表示客户端等待服务器的回复。

- Server 监听到连接请求报文后,如同意建立连接,则向 Client 发送确认。TCP 报文首部中的 SYN 和 ACK 都置 1 ,ack = x + 1 表示期望收到对方下一个报文段的第一个数据字节序号是 x+1,同时表明 x 为止的所有数据都已正确收到(ack=1 其实是 ack=0+1, 也就是期望客户端的第 1 个包),seq = y 表示 Server 自己的初始序号(seq=0 就代表这是服务器这边发出的第 0 号包)。这时服务器进入 syn_rcvd,表示服务器已经收到 Client 的连接请求,等待 client 的确认。

- Client 收到确认后还需再次发送确认,同时携带要发送给 Server 的数据。ACK 置 1 表示确认号 ack= y + 1 有效(代表期望收到服务器的第 1 个包),Client 自己的序号 seq= x + 1(表示这就是我的第 1 个包,相对于第 0 个包来说的),一旦收到 Client 的确认之后,这个 TCP 连接就进入 Established 状态,就可以发起 http 请求了。

看抓包截图:

抓包截图

TCP 为什么需要 3 次握手?

举个例子:假设一个老外在故宫里面迷路了,看到了小明,于是就有下面的对话:

老外: Excuse me,Can you Speak English?

小明: yes 。

老外: OK,I want ...

在问路之前,老外先问小明是否会说英语,小明回答是的,这时老外才开始问路。

2 个计算机通信是靠协议(目前流行的 TCP/IP 协议)来实现,如果 2 个计算机使用的协议不一样,那是不能进行通信的,所以这个 3 次握手就相当于试探一下对方是否遵循 TCP/IP 协议,协商完成后就可以进行通信了,当然这样理解不是那么准确。

为什么 HTTP 协议要基于 TCP 来实现?

目前在 Internet 中所有的传输都是通过 TCP/IP 进行的,HTTP 协议作为 TCP/IP 模型中应用层的协议也不例外,TCP 是一个端到端的可靠的面向连接的协议,所以 HTTP 基于传输层 TCP 协议不用担心数据的传输的各种问题。

经过 TCP3 次握手之后,浏览器发起了 http 的请求(看第⑫包),使用的 http 的方法 GET 方法,请求的 URL 是 / , 协议是 HTTP/1.0:

03175340_4j8z.png

下面是第 12 号包的详细内容:

03175429_kHoP.png

以上的报文是 HTTP 请求报文。那么 HTTP 请求报文和响应报文会是什么格式呢?

起始行:如 GET / HTTP/1.0 (请求的方法 请求的 URL 请求所使用的协议)

头部信息:User-Agent Host 等成对出现的值

主体

不管是请求报文还是响应报文都会遵循以上的格式。那么起始行中的请求方法有哪些种呢?

GET: 完整请求一个资源 (常用)

HEAD: 仅请求响应首部

POST: 提交表单 (常用)

PUT: 上传

DELETE: 删除

OPTIONS: 返回请求的资源所支持的方法的方法

TRACE: 追求一个资源请求中间所经过的代理

那什么是 URL、URI、URN?

URI Uniform Resource Identifier 统一资源标识符,如:scheme://[username:password@] HOST:port/path/to/source

URL Uniform Resource Locator 统一资源定位符,如:http://www.magedu.com/downloads/nginx-1.5.tar.gz

URN Uniform Resource Name 统一资源名称

URL 和 URN 都属于 URI,为了方便就把 URL 和 URI 暂时都通指一个东西。

请求的协议有哪些种?有以下几种:

http/0.9: stateless

http/1.0: MIME, keep-alive (保持连接), 缓存

http/1.1: 更多的请求方法,更精细的缓存控制,持久连接 (persistent connection) 比较常用

下面是 Chrome 发起的 http 请求报文头部信息:

03181252_cIE1.png

Accept 就是告诉服务器端,接受那些 MIME 类型

Accept-Encoding 这个看起来是接受那些压缩方式的文件

Accept-Lanague 告诉服务器能够发送哪些语言

Connection 告诉服务器支持 keep-alive 特性,TCP 连接在发送后将仍然保持打开状态,于是,

浏览器可以继续通过相同的 TCP 连接发送请求。保持连接节省了为每个请求建立新连接所需的时间,还节约了网络带宽。Cookie 每次请求时都会携带上 Cookie 以方便服务器端识别是否是同一个客户端

Host 用来标识请求服务器上的那个虚拟主机,比如 Nginx 里面可以定义很多个虚拟主机,那这里就是用来标识要访问那个虚拟主机。

User-Agent 用户代理,一般情况是浏览器,也有其他类型,如:wget curl 搜索引擎的蜘蛛等

条件请求头部:If-Modified-Since 是浏览器向服务器端询问某个资源文件如果自从什么时间修改过,那么重新发给我,这样就保证服务器端资源文件更新时,浏览器再次去请求,而不是使用缓存中的文件。

安全请求头部:Authorization: 客户端提供给服务器的认证信息;

什么是 MIME?

MIME(Multipurpose Internet Mail Extesions 多用途互联网邮件扩展)是一个互联网标准,它扩展了电子邮件标准,使其能够支持非 ASCII 字符、二进制格式附件等多种格式的邮件消息,这个标准被定义在 RFC 2045、RFC 2046、RFC 2047、RFC 2048、RFC 2049 等 RFC 中。 由 RFC 822 转变而来的 RFC 2822,规定电子邮件标准并不允许在邮件消息中使用 7 位 ASCII 字符集以外的字符。正因如此,一些非英语字符消息和二进制文件,图像,声音等非文字消息都不能在电子邮件中传输。

**MIME 规定了用于表示各种各样的数据类型的符号化方法。**此外,在万维网中使用的 HTTP 协议中也使用了 MIME 的框架,标准被扩展为互联网媒体类型。

MIME 遵循以下格式:major/minor 主类型 / 次类型 例如:

image/jpg

image/gif

text/html

video/quicktime

appliation/x-httpd-php

https://www.cnblogs.com/technologykai/articles/10682612.html

在日常使用 SpringMVC 进行开发的时候,有可能遇到前端各种类型的请求参数,这里做一次相对全面的总结。SpringMVC 中处理控制器参数的接口是 HandlerMethodArgumentResolver,此接口有众多子类,分别处理不同 (注解类型) 的参数,下面只列举几个子类:

实际上,一般在解析一个控制器的请求参数的时候,用到的是 HandlerMethodArgumentResolverComposite,里面装载了所有启用的 HandlerMethodArgumentResolver 子类。而 HandlerMethodArgumentResolver 子类在解析参数的时候使用到 HttpMessageConverter (实际上也是一个列表,进行遍历匹配解析) 子类进行匹配解析,常见的如 MappingJackson2HttpMessageConverter。而 HandlerMethodArgumentResolver 子类到底依赖什么 HttpMessageConverter 实例实际上是由请求头中的 ContentType (在 SpringMVC 中统一命名为 MediaType,见 org.springframework.http.MediaType) 决定的,因此我们在处理控制器的请求参数之前必须要明确外部请求的 ContentType 到底是什么。上面的逻辑可以直接看源码 AbstractMessageConverterMethodArgumentResolver#readWithMessageConverters,思路是比较清晰的。在 @RequestMapping 注解中,produces 和 consumes 就是和请求或者响应的 ContentType 相关的:

另外提一点,SpringMVC 中默认使用 Jackson 作为 JSON 的工具包,如果不是完全理解透整套源码的运作,一般不是十分建议修改默认使用的 MappingJackson2HttpMessageConverter (例如有些人喜欢使用 FastJson,实现 HttpMessageConverter 引入 FastJson 做转换器)。

其实一般的表单或者 JSON 数据的请求都是相对简单的,一些复杂的处理主要包括 URL 路径参数、文件上传、数组或者列表类型数据等。另外,关于参数类型中存在日期类型属性 (例如 java.util.Date、java.sql.Date、java.time.LocalDate、java.time.LocalDateTime),解析的时候一般需要自定义实现的逻辑实现 String-> 日期类型的转换。其实道理很简单,日期相关的类型对于每个国家、每个时区甚至每个使用者来说认知都不一定相同。在演示一些例子主要用到下面的模特类:

@Data

public class User {

private String name;

private Integer age;

private List<Contact> contacts;

}

@Data

public class Contact {

private String name;

private String phone;

}

非对象类型单个参数接收:

这种是最常用的表单参数提交,ContentType 指定为 application/x-www-form-urlencoded,也就是会进行 URL 编码。

spmvc-p-1

对应的控制器如下:

@PostMapping(value = "/post")

public String post(@RequestParam(name = "name") String name,

@RequestParam(name = "age") Integer age) {

String content = String.format("name = %s,age = %d", name, age);

log.info(content);

return content;

}

说实话,如果有毅力的话,所有的复杂参数的提交最终都可以转化为多个单参数接收,不过这样做会产生十分多冗余的代码,而且可维护性比较低。这种情况下,用到的参数处理器是 RequestParamMapMethodArgumentResolver。

对象类型参数接收:

我们接着写一个接口用于提交用户信息,用到的是上面提到的模特类,主要包括用户姓名、年龄和联系人信息列表,这个时候,我们目标的控制器最终编码如下:

@PostMapping(value = "/user")

public User saveUser(User user) {

log.info(user.toString());

return user;

}

我们还是指定 ContentType 为 application/x-www-form-urlencoded,接着我们需要构造请求参数:

spmvc-p-2

因为没有使用注解,最终的参数处理器为 ServletModelAttributeMethodProcessor,主要是把 HttpServletRequest 中的表单参数封装到 MutablePropertyValues 实例中,再通过参数类型实例化 (通过构造反射创建 User 实例),反射匹配属性进行值的填充。另外,请求复杂参数里面的列表属性请求参数看起来比较奇葩,实际上和在. properties 文件中添加最终映射到 Map 类型的参数的写法是一致的。那么,能不能把整个请求参数塞在一个字段中提交呢?

spmvc-p-3

直接这样做是不行的,因为实际提交的 form 表单,key 是 user,value 实际上是一个字符串,缺少一个 String->User 类型的转换器,实际上 RequestParamMethodArgumentResolver 依赖 WebConversionService 中 Converter 列表进行参数转换:

spmvc-p-4

解决办法还是有的,添加一个 org.springframework.core.convert.converter.Converter 实现即可:

@Component

public class StringUserConverter implements Converter<String, User> {

private static final ObjectMapper MAPPER = new ObjectMapper();

@Override

public User convert(String source) {

try {

return MAPPER.readValue(source, User.class);

} catch (IOException e) {

throw new IllegalArgumentException(e);

}

}

}

上面这种做法属于曲线救国的做法,不推荐使用在生产环境,但是如果有些第三方接口的对接无法避免这种参数,可以选择这种实现方式。

一般来说,直接 POST 一个 JSON 字符串这种方式对于 SpringMVC 来说是比较友好的,只需要把 ContentType 设置为 application/json,提交一个原始的 JSON 字符串即可:

spmvc-p-5

后端控制器的代码也比较简单:

@PostMapping(value = "/user-2")

public User saveUser2(@RequestBody User user) {

log.info(user.toString());

return user;

}

因为使用了 @RequestBody 注解,最终使用到的参数处理器为 RequestResponseBodyMethodProcessor,实际上会用到 MappingJackson2HttpMessageConverter 进行参数类型的转换,底层依赖到 Jackson 相关的包。

URL 参数,或者叫请求路径参数是基于 URL 模板获取到的参数,例如 /user/{userId} 是一个 URL 模板 (URL 模板中的参数占位符是 {}),实际请求的 URL 为 /user/1,那么通过匹配实际请求的 URL 和 URL 模板就能提取到 userId 为 1。在 SpringMVC 中,URL 模板中的路径参数叫做 PathVariable,对应注解 @PathVariable,对应的参数处理器为 PathVariableMethodArgumentResolver。注意一点是,@PathVariable 的解析是按照 value (name) 属性进行匹配,和 URL 参数的顺序是无关的。举个简单的例子:

spmvc-p-6

后台的控制器如下:

@GetMapping(value = "/user/{name}/{age}")

public String findUser1(@PathVariable(value = "age") Integer age,

@PathVariable(value = "name") String name) {

String content = String.format("name = %s,age = %d", name, age);

log.info(content);

return content;

}

这种用法被广泛使用于 Representational State Transfer (REST) 的软件架构风格,个人觉得这种风格是比较灵活和清晰的 (从 URL 和请求方法就能完全理解接口的意义和功能)。下面再介绍两种相对特殊的使用方式。

带条件的 URL 参数

其实路径参数支持正则表达式,例如我们在使用 /sex/{sex} 接口的时候,要求 sex 必须是 F (Female) 或者 M (Male),那么我们的 URL 模板可以定义为 /sex/{sex:M|F},代码如下:

@GetMapping(value = "/sex/{sex:M|F}")

public String findUser2(@PathVariable(value = "sex") String sex){

log.info(sex);

return sex;

}

只有 /sex/F 或者 /sex/M 的请求才会进入 findUser2 控制器方法,其他该路径前缀的请求都是非法的,会返回 404 状态码。这里仅仅是介绍了一个最简单的 URL 参数正则表达式的使用方式,更强大的用法可以自行摸索。

@MatrixVariable 的使用

MatrixVariable 也是 URL 参数的一种,对应注解 @MatrixVariable,不过它并不是 URL 中的一个值 (这里的值指定是两个 "/" 之间的部分),而是值的一部分,它通过 ";" 进行分隔,通过 "=" 进行 K-V 设置。说起来有点抽象,举个例子:假如我们需要打电话给一个名字为 doge,性别是男,分组是码畜的程序员,GET 请求的 URL 可以表示为:/call/doge;gender=male;group=programmer,我们设计的控制器方法如下:

@GetMapping(value = "/call/{name}")

public String find(@PathVariable(value = "name") String name,

@MatrixVariable(value = "gender") String gender,

@MatrixVariable(value = "group") String group) {

String content = String.format("name = %s,gender = %s,group = %s", name, gender, group);

log.info(content);

return content;

}

当然,如果你按照上面的例子写好代码,尝试请求一下该接口发现是报错的:400 Bad Request - Missing matrix variable 'gender' for method parameter of type String。这是因为 @MatrixVariable 注解的使用是不安全的,在 SpringMVC 中默认是关闭对其支持。要开启对 @MatrixVariable 的支持,需要设置 RequestMappingHandlerMapping#setRemoveSemicolonContent 方法为 false:

@Configuration

public class CustomMvcConfiguration implements InitializingBean {

@Autowired

private RequestMappingHandlerMapping requestMappingHandlerMapping;

@Override

public void afterPropertiesSet() throws Exception {

requestMappingHandlerMapping.setRemoveSemicolonContent(false);

}

}

除非有很特殊的需要,否则不建议使用 @MatrixVariable。

文件上传在使用 POSTMAN 模拟请求的时候需要选择 form-data,POST 方式进行提交:

spmvc-p-8

假设我们在 D 盘有一个图片文件叫 doge.jpg,现在要通过本地服务接口把文件上传,控制器的代码如下:

@PostMapping(value = "/file1")

public String file1(@RequestPart(name = "file1") MultipartFile multipartFile) {

String content = String.format("name = %s,originName = %s,size = %d",

multipartFile.getName(), multipartFile.getOriginalFilename(), multipartFile.getSize());

log.info(content);

return content;

}

控制台输出是:

name = file1,originName = doge.jpg,size = 68727

可能有点疑惑,参数是怎么来的,我们可以用 Fildder 抓个包看下:

spmvc-p-7

可知 MultipartFile 实例的主要属性分别来自 Content-Disposition、content-type 和 content-length,另外,InputStream 用于读取请求体的最后部分 (文件的字节序列)。参数处理器用到的是 RequestPartMethodArgumentResolver (记住一点,使用了 @RequestPart 和 MultipartFile 一定是使用此参数处理器)。在其他情况下,使用 @RequestParam 和 MultipartFile 或者仅仅使用 MultipartFile (参数的名字必须和 POST 表单中的 Content-Disposition 描述的 name 一致) 也可以接收上传的文件数据,主要是通过 RequestParamMethodArgumentResolver 进行解析处理的,它的功能比较强大,具体可以看其 supportsParameter 方法,这两种情况的控制器方法代码如下:

@PostMapping(value = "/file2")

public String file2(MultipartFile file1) {

String content = String.format("name = %s,originName = %s,size = %d",

file1.getName(), file1.getOriginalFilename(), file1.getSize());

log.info(content);

return content;

}

@PostMapping(value = "/file3")

public String file3(@RequestParam(name = "file1") MultipartFile multipartFile) {

String content = String.format("name = %s,originName = %s,size = %d",

multipartFile.getName(), multipartFile.getOriginalFilename(), multipartFile.getSize());

log.info(content);

return content;

}

其他参数主要包括请求头、Cookie、Model、Map 等相关参数,还有一些并不是很常用或者一些相对原生的属性值获取 (例如 HttpServletRequest、HttpServletResponse 等) 不做讨论。

请求头的值主要通过 @RequestHeader 注解的参数获取,参数处理器是 RequestHeaderMethodArgumentResolver,需要在注解中指定请求头的 Key。简单实用如下:

spmvc-p-9

控制器方法代码:

@PostMapping(value = "/header")

public String header(@RequestHeader(name = "Content-Type") String contentType) {

return contentType;

}

Cookie 的值主要通过 @CookieValue 注解的参数获取,参数处理器为 ServletCookieValueMethodArgumentResolver,需要在注解中指定 Cookie 的 Key。控制器方法代码如下:

@PostMapping(value = "/cookie")

public String cookie(@CookieValue(name = "JSESSIONID") String sessionId) {

return sessionId;

}

Model 类型参数的处理器是 ModelMethodProcessor,实际上处理此参数是直接返回 ModelAndViewContainer 实例中的 Model (ModelMap 类型),因为要桥接不同的接口和类的功能,因此回调的实例是 BindingAwareModelMap 类型,此类型继承自 ModelMap 同时实现了 Model 接口。举个例子:

@GetMapping(value = "/model")

public String model(Model model, ModelMap modelMap) {

log.info("{}", model == modelMap);

return "success";

}

注意调用此接口,控制台输出 Info 日志内容为:true。ModelMap 或者 Model 中添加的属性项会附加到 HttpRequestServlet 中带到页面中进行渲染。

@ModelAttribute 注解处理的参数处理器为 ModelAttributeMethodProcessor,@ModelAttribute 的功能源码的注释如下:

Annotation that binds a method parameter or method return value to a named model attribute, exposed to a web view.

简单来说,就是通过 key-value 形式绑定方法参数或者方法返回值到 Model (Map) 中,区别下面三种情况:

在一个控制器 (使用了 @controller) 中,如果存在一到多个使用了 @ModelAttribute 的方法,这些方法总是在进入控制器方法之前执行,并且执行顺序是由加载顺序决定的 (具体的顺序是带参数的优先,并且按照方法首字母升序排序),举个例子:

@Slf4j

@RestController

public class ModelAttributeController {

@ModelAttribute

public void before(Model model) {

log.info("before..........");

model.addAttribute("before", "beforeValue");

}

@ModelAttribute(value = "beforeArg")

public String beforeArg() {

log.info("beforeArg..........");

return "beforeArgValue";

}

@GetMapping(value = "/modelAttribute")

public String modelAttribute(Model model, @ModelAttribute(value = "beforeArg") String beforeArg) {

log.info("modelAttribute..........");

log.info("beforeArg..........{}", beforeArg);

log.info("{}", model);

return "success";

}

@ModelAttribute

public void after(Model model) {

log.info("after..........");

model.addAttribute("after", "afterValue");

}

@ModelAttribute(value = "afterArg")

public String afterArg() {

log.info("afterArg..........");

return "afterArgValue";

}

}

调用此接口,控制台输出日志如下:

after..........

before..........

afterArg..........

beforeArg..........

modelAttribute..........

beforeArg..........beforeArgValue

{after=afterValue, before=beforeValue, afterArg=afterArgValue, beforeArg=beforeArgValue}

可以印证排序规则和参数设置、获取。

Errors 其实是 BindingResult 的父接口,BindingResult 主要用于回调 JSR 参数校验异常的属性项,如果 JSR 校验异常,一般会抛出 MethodArgumentNotValidException 异常,并且会返回 400 (Bad Request),见全局异常处理器 DefaultHandlerExceptionResolver。Errors 类型的参数处理器为 ErrorsMethodArgumentResolver。举个例子:

@PostMapping(value = "/errors")

public String errors(@RequestBody @Validated ErrorsModel errors, BindingResult bindingResult) {

if (bindingResult.hasErrors()) {

for (ObjectError objectError : bindingResult.getAllErrors()) {

log.warn("name={},message={}", objectError.getObjectName(), objectError.getDefaultMessage());

}

}

return errors.toString();

}

@Data

@NoArgsConstructor

public class ErrorsModel {

@NotNull(message = "id must not be null!")

private Integer id;

@NotEmpty(message = "errors name must not be empty!")

private String name;

}

调用接口控制台 Warn 日志如下:

name=errors,message=errors name must not be empty!

一般情况下,不建议用这种方式处理 JSR 校验异常的属性项,因为会涉及到大量的重复的硬编码工作,建议直接继承 ResponseEntityExceptionHandler,覆盖对应的方法。

控制器方法的参数可以是 @value 注解修饰的参数,会从 Environment 中装配和转换属性值到对应的参数中 (也就是参数的来源并不是请求体),参数处理器为 ExpressionValueMethodArgumentResolver。举个例子:

@GetMapping(value = "/value")

public String value(@Value(value = "${spring.application.name}") String name) {

log.info("spring.application.name={}", name);

return name;

}

Map 类型参数的范围相对比较广,对应一系列的参数处理器,注意区别使用了上面提到的部分注解的 Map 类型和完全不使用注解的 Map 类型参数,两者的处理方式不相同。下面列举几个相对典型的 Map 类型参数处理例子。

不使用任何注解的 Map<String,Object> 参数

这种情况下参数实际上直接回调 ModelAndViewContainer 中的 ModelMap 实例,参数处理器为 MapMethodProcessor,往 Map 参数中添加的属性将会带到页面中。

使用 @RequestParam 注解的 Map<String,Object> 参数

这种情况下的参数处理器为 RequestParamMapMethodArgumentResolver,使用的请求方式需要指定 ContentType 为 x-www-form-urlencoded,不能使用 application/json 的方式:

spmvc-p-10

控制器代码为:

@PostMapping(value = "/map")

public String mapArgs(@RequestParam Map<String, Object> map) {

log.info("{}", map);

return map.toString();

}

使用 @RequestHeader 注解的 Map<String,Object> 参数

这种情况下的参数处理器为 RequestHeaderMapMethodArgumentResolver,作用是获取请求的所有请求头的 Key-Value。

使用 @PathVariable 注解的 Map<String,Object> 参数

这种情况下的参数处理器为 PathVariableMapMethodArgumentResolver,作用是获取所有路径参数封装为 Key-Value 结构。

批量文件上传的时候,我们一般需要接收一个 MultipartFile 集合,可以有两种选择:

getFiles 方法获取 MultipartFile 列表。spmvc-p-11

控制器方法代码如下:

@PostMapping(value = "/parts")

public String partArgs(@RequestParam(name = "file") List<MultipartFile> parts) {

log.info("{}", parts);

return parts.toString();

}

日期处理个人认为是请求参数处理中最复杂的,因为一般日期处理的逻辑不是通用的,过多的定制化处理导致很难有一个统一的标准处理逻辑去处理和转换日期类型的参数。不过,这里介绍几个通用的方法,以应对各种奇葩的日期格式。下面介绍的例子中全部使用 Jdk8 中引入的日期时间 API,围绕 java.util.Date 为核心的日期时间 API 的使用方式类同。

这种是最原始但是最奏效的方式,统一以字符串形式接收,然后自行处理类型转换,下面给个小例子:

@PostMapping(value = "/date1")

public String date1(@RequestBody UserDto userDto) {

UserEntity userEntity = new UserEntity();

userEntity.setUserId(userDto.getUserId());

userEntity.setBirthdayTime(LocalDateTime.parse(userDto.getBirthdayTime(), FORMATTER));

userEntity.setGraduationTime(LocalDateTime.parse(userDto.getGraduationTime(), FORMATTER));

log.info(userEntity.toString());

return "success";

}

@Data

public class UserDto {

private String userId;

private String birthdayTime;

private String graduationTime;

}

@Data

public class UserEntity {

private String userId;

private LocalDateTime birthdayTime;

private LocalDateTime graduationTime;

}

spmvc-p-12

@DateTimeFormat 注解配合 @RequestBody 的参数使用的时候,会发现抛出 InvalidFormatException 异常,提示转换失败,这是因为在处理此注解的时候,只支持 form 提交 (ContentType 为 x-www-form-urlencoded),例子如下:

spmvc-p-13

@Data

public class UserDto2 {

private String userId;

@DateTimeFormat(pattern = "yyyy-MM-dd HH:mm:ss")

private LocalDateTime birthdayTime;

@DateTimeFormat(pattern = "yyyy-MM-dd HH:mm:ss")

private LocalDateTime graduationTime;

}

@PostMapping(value = "/date2")

public String date2(UserDto2 userDto2) {

log.info(userDto2.toString());

return "success";

}

@PostMapping(value = "/date2")

public String date2(@RequestParam("name"="userId")String userId,

@RequestParam("name"="birthdayTime")LocalDateTime birthdayTime,

@RequestParam("name"="graduationTime")LocalDateTime graduationTime) {

return "success";

}

而 @jsonformat 注解可使用在 form 或者 Json 请求参数的场景,因此更推荐使用 @jsonformat 注解,不过注意需要指定时区 (timezone 属性,例如在**是东八区 "GMT+8"),否则有可能导致出现 "时差",举个例子:

@PostMapping(value = "/date2")

public String date2(@RequestBody UserDto2 userDto2) {

log.info(userDto2.toString());

return "success";

}

@Data

public class UserDto2 {

private String userId;

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime birthdayTime;

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime graduationTime;

}

因为 SpringMVC 默认使用 Jackson 处理 @RequestBody 的参数转换,因此可以通过定制序列化器和反序列化器来实现日期类型的转换,这样我们就可以使用 application/json 的形式提交请求参数。这里的例子是转换请求 Json 参数中的字符串为 LocalDateTime 类型,属于 Json 反序列化,因此需要定制反序列化器:

@PostMapping(value = "/date3")

public String date3(@RequestBody UserDto3 userDto3) {

log.info(userDto3.toString());

return "success";

}

@Data

public class UserDto3 {

private String userId;

@JsonDeserialize(using = CustomLocalDateTimeDeserializer.class)

private LocalDateTime birthdayTime;

@JsonDeserialize(using = CustomLocalDateTimeDeserializer.class)

private LocalDateTime graduationTime;

}

public class CustomLocalDateTimeDeserializer extends LocalDateTimeDeserializer {

public CustomLocalDateTimeDeserializer() {

super(DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss"));

}

}

前面三种方式都存在硬编码等问题,其实最佳实践是直接修改 MappingJackson2HttpMessageConverter 中的 ObjectMapper 对于日期类型处理默认的序列化器和反序列化器,这样就能全局生效,不需要再使用其他注解或者定制序列化方案 (当然,有些时候需要特殊处理定制),或者说,在需要特殊处理的场景才使用其他注解或者定制序列化方案。使用钩子接口 Jackson2ObjectMapperBuilderCustomizer 可以实现 ObjectMapper 的属性定制:

@Bean

public Jackson2ObjectMapperBuilderCustomizer jackson2ObjectMapperBuilderCustomizer(){

return customizer->{

customizer.serializerByType(LocalDateTime.class,new LocalDateTimeSerializer(

DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss")));

customizer.deserializerByType(LocalDateTime.class,new LocalDateTimeDeserializer(

DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss")));

};

}

这样就能定制化 MappingJackson2HttpMessageConverter 中持有的 ObjectMapper,上面的 LocalDateTime 序列化和反序列化器对全局生效。

前面基本介绍完了主流的请求参数处理,其实 SpringMVC 中还会按照 URL 的模式进行匹配,使用的是 Ant 路径风格,处理工具类为 org.springframework.util.AntPathMatcher,从此类的注释来看,匹配规则主要包括下面四点:

? 匹配 1 个字符。* 匹配 0 个或者多个字符。** 匹配路径中 0 个或者多个目录。{spring:[a-z]+} 将正则表达式 [a-z]+ 匹配到的值,赋值给名为 spring 的路径变量。举些例子:

? 形式的 URL:

@GetMapping(value = "/pattern?")

public String pattern() {

return "success";

}

/pattern 404 Not Found

/patternd 200 OK

/patterndd 404 Not Found

/pattern/ 404 Not Found

/patternd/s 404 Not Found

* 形式的 URL:

@GetMapping(value = "/pattern*")

public String pattern() {

return "success";

}

/pattern 200 OK

/pattern/ 200 OK

/patternd 200 OK

/pattern/a 404 Not Found

** 形式的 URL:

@GetMapping(value = "/pattern/**/p")

public String pattern() {

return "success";

}

/pattern/p 200 OK

/pattern/x/p 200 OK

/pattern/x/y/p 200 OK

{spring:[a-z]+} 形式的 URL:

@GetMapping(value = "/pattern/{key:[a-c]+}")

public String pattern(@PathVariable(name = "key") String key) {

return "success";

}

/pattern/a 200 OK

/pattern/ab 200 OK

/pattern/abc 200 OK

/pattern 404 Not Found

/pattern/abcd 404 Not Found

上面的四种 URL 模式可以组合使用,千变万化。

URL 匹配还遵循精确匹配原则,也就是存在两个模式对同一个 URL 都能够匹配成功,则选取最精确的 URL 匹配,进入对应的控制器方法,举个例子:

@GetMapping(value = "/pattern/**/p")

public String pattern1() {

return "success";

}

@GetMapping(value = "/pattern/p")

public String pattern2() {

return "success";

}

上面两个控制器,如果请求 URL 为 /pattern/p,最终进入的方法为 pattern2。

最后,org.springframework.util.AntPathMatcher 作为一个工具类,可以单独使用,不仅仅可以用于匹配 URL,也可以用于匹配系统文件路径,不过需要使用其带参数构造改变内部的 pathSeparator 变量,例如:

AntPathMatcher antPathMatcher = new AntPathMatcher(File.separator);

笔者在前一段时间曾经花大量时间梳理和分析过 Spring、SpringMVC 的源码,但是后面一段很长的时间需要进行业务开发,对架构方面的东西有点生疏了,毕竟东西不用就会生疏,这个是常理。这篇文章基于一些 SpringMVC 的源码经验总结了请求参数的处理相关的一些知识,希望帮到自己和大家。

参考资料:

1. 在静态方法中是不能使用 this 预定义对象引用的 , 即使其后边所操作的也是静态成员也不行.

因为 this 代表的是调用这个函数的对象的引用 , 而静态方法是属于类的 , 不属于对象 , 静态方法成功加载后 , 对象还不一定存在

2. 在问题之前先讲 super 的用法:

1.super 的用法跟 this 类似,this 代表对本类对象的引用,指向本类已经创建的对象;而 super 代表对父类对象的引用,指向父类对象;

2. 静态优先于对象存在;

3. 由上面的 1. 和 2. 知:

因为静态优先于对象存在,所以方法被静态修饰之后方法先存在,而方法里面要用到 super 指向的父类对象,但是所需的父类引用对象晚于该方法出现,也就是 super 所指向的对象没有,当然就会出错。

综上,静态方法中不可以出现 super 关键字。

3. 首先你要明白对象和类的区别。

this 和 super 是属于对象范畴的东西,而静态方法是属于类范畴的东西

所有的成员方法 , 都有一个默认的的参数 this(即使是无参的方法), 只要是成员方法 , 编译器就会给你加上 this 这个参数如:

Class A 中

void method1(){} 实际上是这样的 --------> void method1(A this)

void method2(int x){} 实际上是这样的 --------> void method2(A this, intx) 而静态方法与对象无关 , 根本不能把对象的引用传到方法中 , 所以不能用 this

4. 在一个类中定义一个方法为 static,则为静态方法,那就是说,无需本类的对象即可调用此方法,调用一个静态方法就是 “类名. 方法名” 既然 "无需本类的对象即可调用静态方法",而 this 和 super 关键字都是用于本类对象的-----调用静态方法无需本类的对象这句话很清楚表明:静态方法中不能用 this 和 super 关键字

5. 静态方法是存放在内存中的数据段里,this 和 super 调用的是堆空间里的应用对象不能调用数据段区域里的数据,因此静态方法中不能用 this 和 super 关键字

6. 静态方法和静态类不属于单个对象,而是类的所有对象共享使用

而 this 代表当前对象

7. 东西只属于类,不属于任何对象,所以不能用 THIS 和 SUPER。

https://blog.csdn.net/u010479322/article/details/51730275

众所周知,因为疫情的原因,很多高校和公司都要求员工每日在微信上进行打卡,来汇报自己的当前身体状态和所处地区。但绝大多数情况下,每天打卡的信息其实是不会变的,我们要做的就是进入公众号——自动登录点进打卡页面——完成打卡,这样重复的操作。

这样的操作在手机上需要花费的时间应该不足一分钟,但依旧每天都会有懒得或者忘了进行操作的人。所以就想到能不能用 python 写一个脚本,在 PC 端进行自动打卡呢?

(本操作仅提供思路参考,大家还是要重视防疫打卡操作)

以下所有操作均以某高校页面为例

目录

2. 代码实现(Cookie + 纯 requests 版本)

3. 代码实现(账号密码 + Selenium+Requests 版本)

由于微信的普及,所以基本各高校和公司每日打卡都是在微信端进行,所以我们需要通过微信找到我们的登录页。

公众号进入打卡页面标题

标题选择复制链接地址

我们最终希望用Requests模拟发包登录,而平时都是直接用微信进行自动登录。显然在只用脚本的情况下没办法实现微信自动登录跳转,所以我们需要先找到能输入账号密码的页面。(此时没有用 Cookie 是因为实验之后发现,Cookie 有效期不到 2 小时,没办法支撑每日用同一个 Cookie 登录打卡)

此时,我们通过 PC 微信找到该链接:http://****app.i****.info/NYDXY/#/,但是如果直接用浏览器打开该链接,会跳转” 请用微信客户端打开链接 “的页面。

标题直接用浏览器打开出错

因此,需要想办法绕过该限制,思路有两个:1. 通过 Fiddler 等抓包软件,找找有没有其他登录页面。2. 模拟微信浏览器的请求头和 Cookie 进入。但是正如前文所说,经过尝试思路 2,确实能够完成全流程,但该页面 Cookie 有效期很短,没办法每日均进行自动打卡,因此我们选择尝试思路 1,还是通过账号密码登录。

沿着思路 1,我们打开 Fiddler,启动抓包。然后回到 PC 微信,和刚才同样的操作进入打卡页面自动登录,再回到 Fiddler,发现刚才进入打卡页面的所有操作已经被记录在软件里了。接下来就是通过 url 和请求头等信息,来判断是否存在其他的登录页面。

红框所示为抓包所得

经过分析和尝试,前两个链接都会提示 400 或其他错误,但尝试到第三个链接时,会跳转到学校的统一登陆页面,同时还在下方发现微信快捷登录图表。通过该页面输入账号密码后,浏览器自动跳转到了我们所需的打卡页面了。此时,我们实现了 PC 端模拟登录微信打卡页面。

统一登录页面

浏览器成功登入打卡页面

第二步,我们需要看我们打卡到底在浏览器端是如何完成的。在手动进行打卡操作之后,经过浏览器的 F12,看到有四个 php 提供了 post 操作,而通常我们的表单数据都是由 post 方法完成的。排除掉之前就存在的第一二个 php,所以我们强烈怀疑就是通过这剩余两个 php 完成的打卡操作。

怀疑的 jump.php

具体来看发现,最后一个 jump.php 实际上返回的是个人基本信息,以供自动填充用的,提交的表单也与打卡无关。

最后的 jump.php 返回的结果

但到了倒数第二个 jump.php,通过其提交的 Form 数据,我们发现就是通过这个 php 我们完成了打卡操作。因此得知,我们的最终目标,就是通过该 php 来完成我们的自动打卡。至此,我们的代码前分析全部完成,接下来进入代码环节。

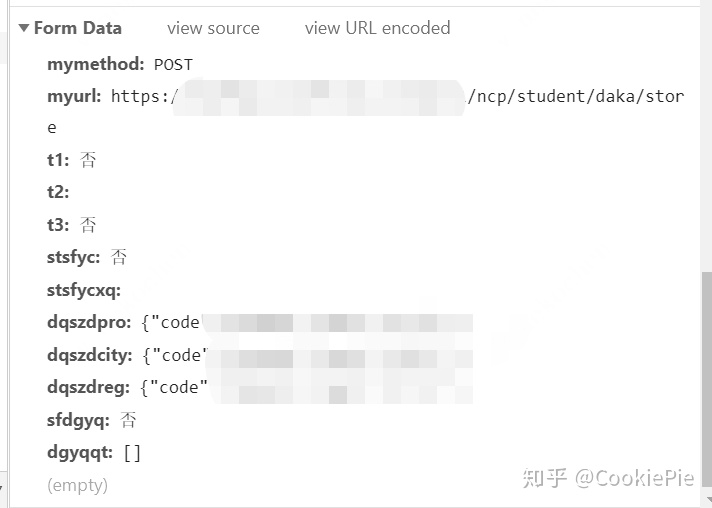

倒数第二个 php 提交的表单

( 此版本使用 requests 包进行 python 代码实现)

因为我们已经通过浏览器进行过登录,获得了 Cookie,所以我们先尝试通过 Cookie 进行直接打卡。先通过浏览器 F12 获得 Cookie 和其余请求头,然后根据需要放在 Python 文件中。(这里的请求头大家可以选择需要的来放,一般加上Cookie 和 User-Agent即可,如果失败还可以尝试将 User-Agent 换为 Android 或 ios 的模拟请求)

右侧为请求头

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.193 Safari/537.36','Cookie': '浏览器上找到的Cookie'```

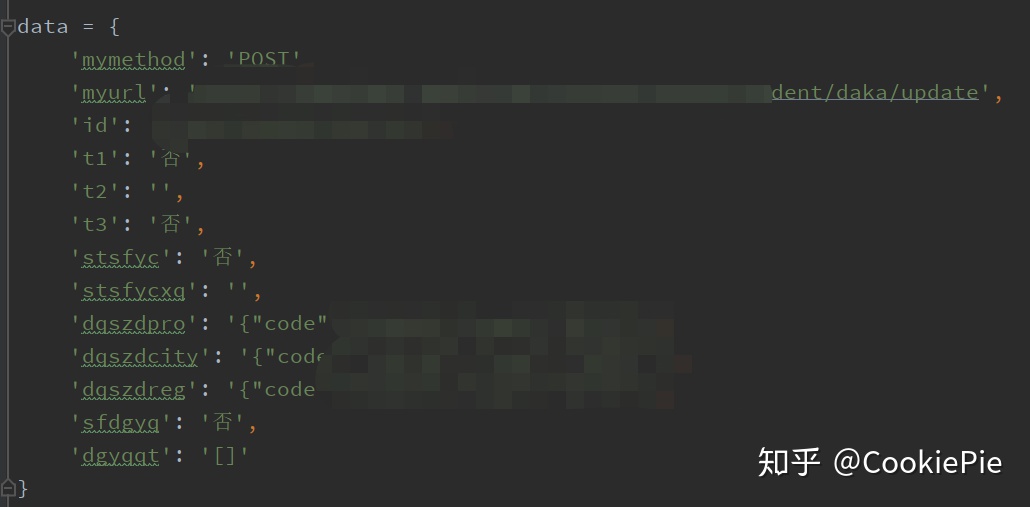

然后再根据From Data的数据,按照字典格式一一放进Python文件中去。

From Data数据

Python文件格式

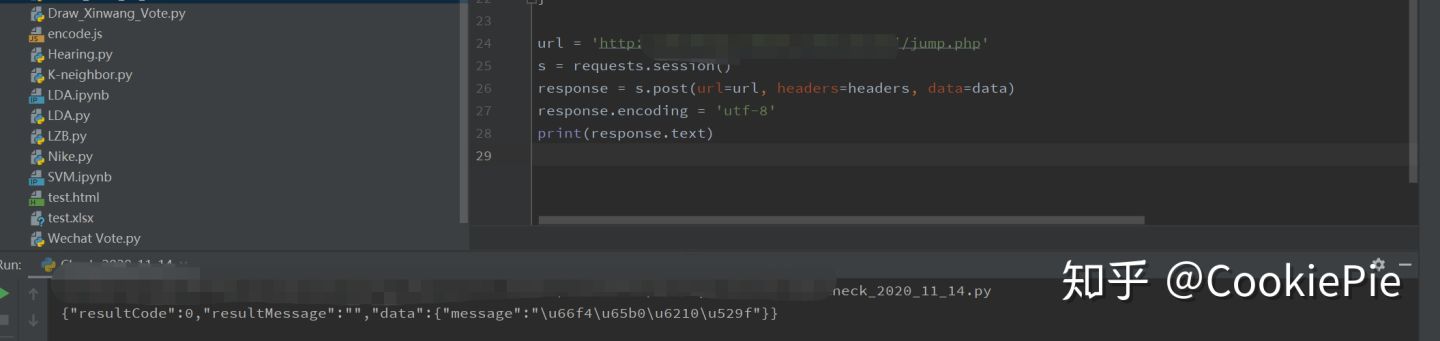

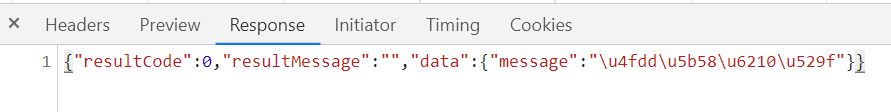

最后再尝试post即可。发现最后返回值和浏览器返回值相同,打卡成功。

```null

url = 'http://****app.i****.info/jinzhi/jump.php'response = s.post(url=url, headers=headers, data=data)response.encoding = 'utf-8'```

Python返回值

浏览器返回值

3.代码实现(账号密码+Selenium+Requests版本)

--------------------------------

前文已经实现在知道Cookie的前提下,可以直接通过固定php页面进行表单上传打卡。但是由于Cookie有效期极短,所以我们明显需要有一个每次打卡前自动获取Cookie的方法。

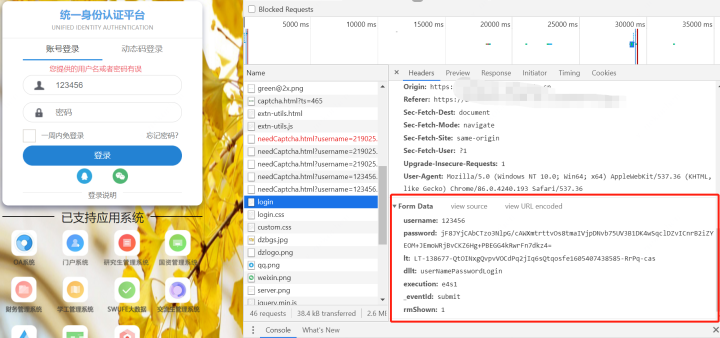

回到一开始的Login页面,同样我们通过F12抓包,看每次登录时提交的表单具体值有些什么。在用户名和密码,我们尝试性的输入123456之后点击提交,会发现在login文件下会POST一个表单,里面所包含的就是每次登录要传给服务器的信息了。

登录信息

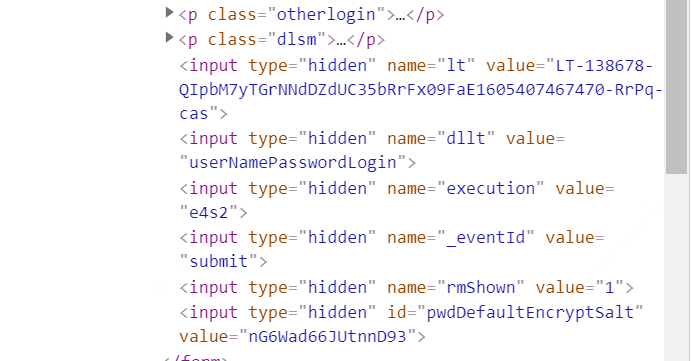

但是从表单我们看到,除了我们填写的账号密码,还有包括lt,execution等信息。经过查找,我们发现这些信息是在加载网页时就自动生成的,所以我们可以通过request.session()的方法进入页面后,再通过正则表达式将所需信息找出来,和账号密码一起形成表单。

页面隐藏的元素

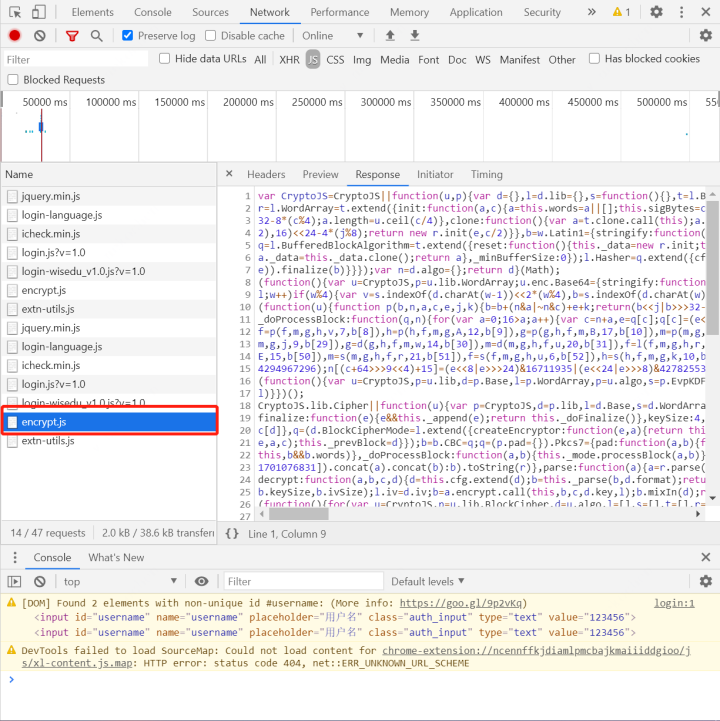

但是我们还可以看到,password明显是经过加密处理后的信息,所以我们不能直接明文提交密码,要想办法将密码进行处理。而这个加密后的密码,是我们点击提交后网页自动将我们的明文密码进行的加密,所以大概率就是一个js的处理,因此需要找到网页上加密的js文件。查找login页面和js之后,最终找到是encrypt.js这个文件完成了明文密码的加密。

加密js

按逻辑来说,我们此时就可以查找传递该js所需参数,得到加密后的密码,连同其他信息一起post给login就可以完成我们的登录和cookie获取了。但是这个js真是又长又混淆,以现在的水平暂时不能找到其所需参数。所以换了个思路,通过Selenium来模拟登录,直接获取Cookie。

(这里如果可以看懂这个js加密的话,是完全可以不依靠Selenium获取Cookie的,大家有兴趣可以尝试一下)

Selenium就比较简单了,通过分析登录页面,找到需要Input的地方,获取Xpath,再通过Selenium填写,并获取Cookie就可以了。

通过F12得到元素的Xpath

```null

def get_cookie(url_, user_): driver = webdriver.Chrome() driver.find_element_by_xpath('//*[@id="username"]').send_keys(user_['name']) driver.find_element_by_xpath('//*[@id="password"]').send_keys(user_['password']) driver.find_element_by_xpath('//*[@id="casLoginForm"]/p[4]/button').click() cookie_ = driver.get_cookies()[0] return cookie_['name']+'='+cookie_['value']```

获取cookie后,和之前操作相同,提交表单即可,完整代码如下。

```null

from selenium import webdriverdef get_cookie(url_, user_): driver = webdriver.Chrome() driver.find_element_by_xpath('//*[@id="username"]').send_keys(user_['name']) driver.find_element_by_xpath('//*[@id="password"]').send_keys(user_['password']) driver.find_element_by_xpath('//*[@id="casLoginForm"]/p[4]/button').click() cookie_ = driver.get_cookies()[0]return cookie_['name']+'='+cookie_['value']user = {'name': '', 'password': ''}cookie = get_cookie('https://authserver.*****.edu.cn/authserver/login?service=http://*****app.i*****.info/jinzhi/index.php', user)'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.193 Safari/537.36','myurl': 'https://*****api.*****.edu.cn/api/v1/ncp/student/daka/update','dqszdpro': '{"code":""}','dqszdcity': '{"code":""}','dqszdreg': '{"code":""}',url = 'http://*****app.i*****.info/jinzhi/jump.php'response = s.post(url=url, headers=headers, data=data)```

4.总结

----

其实在类似需求中,代码部分相对而言占比更少,重要的地方在于找到提交的表单数据和页面链接,和能否完成加密解密。本文由于js加密的限制,只能通过Selenium来获取Cookie进而实现表单提交。在之后的版本中,希望能够通过分析js文件,完成参数传递加密,最终只用Requests包完成打卡操作。

与本文类似的应用场景还有很多,都可以用相同的思路去解决,本文作为供大家选择的参考,如果各位读者有更好的思路欢迎多多交流。

[https://blog.csdn.net/CookiePie/article/details/109698484](https://blog.csdn.net/CookiePie/article/details/109698484)

0.2932018.08.07 01:21:20 字数 4,800 阅读 1,372

在日常使用 SpringMVC 进行开发的时候,有可能遇到前端各种类型的请求参数,这里做一次相对全面的总结。SpringMVC 中处理控制器参数的接口是 HandlerMethodArgumentResolver,此接口有众多子类,分别处理不同 (注解类型) 的参数,下面只列举几个子类:

实际上,一般在解析一个控制器的请求参数的时候,用到的是 HandlerMethodArgumentResolverComposite,里面装载了所有启用的 HandlerMethodArgumentResolver 子类。而 HandlerMethodArgumentResolver 子类在解析参数的时候使用到 HttpMessageConverter (实际上也是一个列表,进行遍历匹配解析) 子类进行匹配解析,常见的如 MappingJackson2HttpMessageConverter。而 HandlerMethodArgumentResolver 子类到底依赖什么 HttpMessageConverter 实例实际上是由请求头中的 ContentType (在 SpringMVC 中统一命名为 MediaType,见 org.springframework.http.MediaType) 决定的,因此我们在处理控制器的请求参数之前必须要明确外部请求的 ContentType 到底是什么。上面的逻辑可以直接看源码 AbstractMessageConverterMethodArgumentResolver#readWithMessageConverters,思路是比较清晰的。在 @RequestMapping 注解中,produces 和 consumes 就是和请求或者响应的 ContentType 相关的:

另外提一点,SpringMVC 中默认使用 Jackson 作为 JSON 的工具包,如果不是完全理解透整套源码的运作,一般不是十分建议修改默认使用的 MappingJackson2HttpMessageConverter (例如有些人喜欢使用 FastJson,实现 HttpMessageConverter 引入 FastJson 做转换器)。

其实一般的表单或者 JSON 数据的请求都是相对简单的,一些复杂的处理主要包括 URL 路径参数、文件上传、数组或者列表类型数据等。另外,关于参数类型中存在日期类型属性 (例如 java.util.Date、java.sql.Date、java.time.LocalDate、java.time.LocalDateTime),解析的时候一般需要自定义实现的逻辑实现 String-> 日期类型的转换。其实道理很简单,日期相关的类型对于每个国家、每个时区甚至每个使用者来说认知都不一定相同。在演示一些例子主要用到下面的模特类:

@Data

public class User {

private String name;

private Integer age;

private List<Contact> contacts;

}

@Data

public class Contact {

private String name;

private String phone;

}

非对象类型单个参数接收:

这种是最常用的表单参数提交,ContentType 指定为 application/x-www-form-urlencoded,也就是会进行 URL 编码。

spmvc-p-1

对应的控制器如下:

@PostMapping(value = "/post")

public String post(@RequestParam(name = "name") String name,

@RequestParam(name = "age") Integer age) {

String content = String.format("name = %s,age = %d", name, age);

log.info(content);

return content;

}

说实话,如果有毅力的话,所有的复杂参数的提交最终都可以转化为多个单参数接收,不过这样做会产生十分多冗余的代码,而且可维护性比较低。这种情况下,用到的参数处理器是 RequestParamMapMethodArgumentResolver。

对象类型参数接收:

我们接着写一个接口用于提交用户信息,用到的是上面提到的模特类,主要包括用户姓名、年龄和联系人信息列表,这个时候,我们目标的控制器最终编码如下:

@PostMapping(value = "/user")

public User saveUser(User user) {

log.info(user.toString());

return user;

}

我们还是指定 ContentType 为 application/x-www-form-urlencoded,接着我们需要构造请求参数:

spmvc-p-2

因为没有使用注解,最终的参数处理器为 ServletModelAttributeMethodProcessor,主要是把 HttpServletRequest 中的表单参数封装到 MutablePropertyValues 实例中,再通过参数类型实例化 (通过构造反射创建 User 实例),反射匹配属性进行值的填充。另外,请求复杂参数里面的列表属性请求参数看起来比较奇葩,实际上和在. properties 文件中添加最终映射到 Map 类型的参数的写法是一致的。那么,能不能把整个请求参数塞在一个字段中提交呢?

spmvc-p-3

直接这样做是不行的,因为实际提交的 form 表单,key 是 user,value 实际上是一个字符串,缺少一个 String->User 类型的转换器,实际上 RequestParamMethodArgumentResolver 依赖 WebConversionService 中 Converter 列表进行参数转换:

spmvc-p-4

解决办法还是有的,添加一个 org.springframework.core.convert.converter.Converter 实现即可:

@Component

public class StringUserConverter implements Converter<String, User> {

private static final ObjectMapper MAPPER = new ObjectMapper();

@Override

public User convert(String source) {

try {

return MAPPER.readValue(source, User.class);

} catch (IOException e) {

throw new IllegalArgumentException(e);

}

}

}

上面这种做法属于曲线救国的做法,不推荐使用在生产环境,但是如果有些第三方接口的对接无法避免这种参数,可以选择这种实现方式。

一般来说,直接 POST 一个 JSON 字符串这种方式对于 SpringMVC 来说是比较友好的,只需要把 ContentType 设置为 application/json,提交一个原始的 JSON 字符串即可:

spmvc-p-5

后端控制器的代码也比较简单:

@PostMapping(value = "/user-2")

public User saveUser2(@RequestBody User user) {

log.info(user.toString());

return user;

}

因为使用了 @RequestBody 注解,最终使用到的参数处理器为 RequestResponseBodyMethodProcessor,实际上会用到 MappingJackson2HttpMessageConverter 进行参数类型的转换,底层依赖到 Jackson 相关的包。

URL 参数,或者叫请求路径参数是基于 URL 模板获取到的参数,例如 /user/{userId} 是一个 URL 模板 (URL 模板中的参数占位符是 {}),实际请求的 URL 为 /user/1,那么通过匹配实际请求的 URL 和 URL 模板就能提取到 userId 为 1。在 SpringMVC 中,URL 模板中的路径参数叫做 PathVariable,对应注解 @PathVariable,对应的参数处理器为 PathVariableMethodArgumentResolver。注意一点是,@PathVariable 的解析是按照 value (name) 属性进行匹配,和 URL 参数的顺序是无关的。举个简单的例子:

spmvc-p-6

后台的控制器如下:

@GetMapping(value = "/user/{name}/{age}")

public String findUser1(@PathVariable(value = "age") Integer age,

@PathVariable(value = "name") String name) {

String content = String.format("name = %s,age = %d", name, age);

log.info(content);

return content;

}

这种用法被广泛使用于 Representational State Transfer (REST) 的软件架构风格,个人觉得这种风格是比较灵活和清晰的 (从 URL 和请求方法就能完全理解接口的意义和功能)。下面再介绍两种相对特殊的使用方式。

带条件的 URL 参数

其实路径参数支持正则表达式,例如我们在使用 /sex/{sex} 接口的时候,要求 sex 必须是 F (Female) 或者 M (Male),那么我们的 URL 模板可以定义为 /sex/{sex:M|F},代码如下:

@GetMapping(value = "/sex/{sex:M|F}")

public String findUser2(@PathVariable(value = "sex") String sex){

log.info(sex);

return sex;

}

只有 /sex/F 或者 /sex/M 的请求才会进入 findUser2 控制器方法,其他该路径前缀的请求都是非法的,会返回 404 状态码。这里仅仅是介绍了一个最简单的 URL 参数正则表达式的使用方式,更强大的用法可以自行摸索。

@MatrixVariable 的使用

MatrixVariable 也是 URL 参数的一种,对应注解 @MatrixVariable,不过它并不是 URL 中的一个值 (这里的值指定是两个 "/" 之间的部分),而是值的一部分,它通过 ";" 进行分隔,通过 "=" 进行 K-V 设置。说起来有点抽象,举个例子:假如我们需要打电话给一个名字为 doge,性别是男,分组是码畜的程序员,GET 请求的 URL 可以表示为:/call/doge;gender=male;group=programmer,我们设计的控制器方法如下:

@GetMapping(value = "/call/{name}")

public String find(@PathVariable(value = "name") String name,

@MatrixVariable(value = "gender") String gender,

@MatrixVariable(value = "group") String group) {

String content = String.format("name = %s,gender = %s,group = %s", name, gender, group);

log.info(content);

return content;

}

当然,如果你按照上面的例子写好代码,尝试请求一下该接口发现是报错的:400 Bad Request - Missing matrix variable 'gender' for method parameter of type String。这是因为 @MatrixVariable 注解的使用是不安全的,在 SpringMVC 中默认是关闭对其支持。要开启对 @MatrixVariable 的支持,需要设置 RequestMappingHandlerMapping#setRemoveSemicolonContent 方法为 false:

@Configuration

public class CustomMvcConfiguration implements InitializingBean {

@Autowired

private RequestMappingHandlerMapping requestMappingHandlerMapping;

@Override

public void afterPropertiesSet() throws Exception {

requestMappingHandlerMapping.setRemoveSemicolonContent(false);

}

}

除非有很特殊的需要,否则不建议使用 @MatrixVariable。

文件上传在使用 POSTMAN 模拟请求的时候需要选择 form-data,POST 方式进行提交:

spmvc-p-8

假设我们在 D 盘有一个图片文件叫 doge.jpg,现在要通过本地服务接口把文件上传,控制器的代码如下:

@PostMapping(value = "/file1")

public String file1(@RequestPart(name = "file1") MultipartFile multipartFile) {

String content = String.format("name = %s,originName = %s,size = %d",

multipartFile.getName(), multipartFile.getOriginalFilename(), multipartFile.getSize());

log.info(content);

return content;

}

控制台输出是:

name = file1,originName = doge.jpg,size = 68727

可能有点疑惑,参数是怎么来的,我们可以用 Fildder 抓个包看下:

spmvc-p-7

可知 MultipartFile 实例的主要属性分别来自 Content-Disposition、content-type 和 content-length,另外,InputStream 用于读取请求体的最后部分 (文件的字节序列)。参数处理器用到的是 RequestPartMethodArgumentResolver (记住一点,使用了 @RequestPart 和 MultipartFile 一定是使用此参数处理器)。在其他情况下,使用 @RequestParam 和 MultipartFile 或者仅仅使用 MultipartFile (参数的名字必须和 POST 表单中的 Content-Disposition 描述的 name 一致) 也可以接收上传的文件数据,主要是通过 RequestParamMethodArgumentResolver 进行解析处理的,它的功能比较强大,具体可以看其 supportsParameter 方法,这两种情况的控制器方法代码如下:

@PostMapping(value = "/file2")

public String file2(MultipartFile file1) {

String content = String.format("name = %s,originName = %s,size = %d",

file1.getName(), file1.getOriginalFilename(), file1.getSize());

log.info(content);

return content;

}

@PostMapping(value = "/file3")

public String file3(@RequestParam(name = "file1") MultipartFile multipartFile) {

String content = String.format("name = %s,originName = %s,size = %d",

multipartFile.getName(), multipartFile.getOriginalFilename(), multipartFile.getSize());

log.info(content);

return content;

}

其他参数主要包括请求头、Cookie、Model、Map 等相关参数,还有一些并不是很常用或者一些相对原生的属性值获取 (例如 HttpServletRequest、HttpServletResponse 等) 不做讨论。

请求头的值主要通过 @RequestHeader 注解的参数获取,参数处理器是 RequestHeaderMethodArgumentResolver,需要在注解中指定请求头的 Key。简单实用如下:

spmvc-p-9

控制器方法代码:

@PostMapping(value = "/header")

public String header(@RequestHeader(name = "Content-Type") String contentType) {

return contentType;

}

Cookie 的值主要通过 @CookieValue 注解的参数获取,参数处理器为 ServletCookieValueMethodArgumentResolver,需要在注解中指定 Cookie 的 Key。控制器方法代码如下:

@PostMapping(value = "/cookie")

public String cookie(@CookieValue(name = "JSESSIONID") String sessionId) {

return sessionId;

}

Model 类型参数的处理器是 ModelMethodProcessor,实际上处理此参数是直接返回 ModelAndViewContainer 实例中的 Model (ModelMap 类型),因为要桥接不同的接口和类的功能,因此回调的实例是 BindingAwareModelMap 类型,此类型继承自 ModelMap 同时实现了 Model 接口。举个例子:

@GetMapping(value = "/model")

public String model(Model model, ModelMap modelMap) {

log.info("{}", model == modelMap);

return "success";

}

注意调用此接口,控制台输出 Info 日志内容为:true。ModelMap 或者 Model 中添加的属性项会附加到 HttpRequestServlet 中带到页面中进行渲染。

@ModelAttribute 注解处理的参数处理器为 ModelAttributeMethodProcessor,@ModelAttribute 的功能源码的注释如下:

Annotation that binds a method parameter or method return value to a named model attribute, exposed to a web view.

简单来说,就是通过 key-value 形式绑定方法参数或者方法返回值到 Model (Map) 中,区别下面三种情况:

在一个控制器 (使用了 @controller) 中,如果存在一到多个使用了 @ModelAttribute 的方法,这些方法总是在进入控制器方法之前执行,并且执行顺序是由加载顺序决定的 (具体的顺序是带参数的优先,并且按照方法首字母升序排序),举个例子:

@Slf4j

@RestController

public class ModelAttributeController {

@ModelAttribute

public void before(Model model) {

log.info("before..........");

model.addAttribute("before", "beforeValue");

}

@ModelAttribute(value = "beforeArg")

public String beforeArg() {

log.info("beforeArg..........");

return "beforeArgValue";

}

@GetMapping(value = "/modelAttribute")

public String modelAttribute(Model model, @ModelAttribute(value = "beforeArg") String beforeArg) {

log.info("modelAttribute..........");

log.info("beforeArg..........{}", beforeArg);

log.info("{}", model);

return "success";

}

@ModelAttribute

public void after(Model model) {

log.info("after..........");

model.addAttribute("after", "afterValue");

}

@ModelAttribute(value = "afterArg")

public String afterArg() {

log.info("afterArg..........");

return "afterArgValue";

}

}

调用此接口,控制台输出日志如下:

after..........

before..........

afterArg..........

beforeArg..........

modelAttribute..........

beforeArg..........beforeArgValue

{after=afterValue, before=beforeValue, afterArg=afterArgValue, beforeArg=beforeArgValue}

可以印证排序规则和参数设置、获取。

Errors 其实是 BindingResult 的父接口,BindingResult 主要用于回调 JSR 参数校验异常的属性项,如果 JSR 校验异常,一般会抛出 MethodArgumentNotValidException 异常,并且会返回 400 (Bad Request),见全局异常处理器 DefaultHandlerExceptionResolver。Errors 类型的参数处理器为 ErrorsMethodArgumentResolver。举个例子:

@PostMapping(value = "/errors")

public String errors(@RequestBody @Validated ErrorsModel errors, BindingResult bindingResult) {

if (bindingResult.hasErrors()) {

for (ObjectError objectError : bindingResult.getAllErrors()) {

log.warn("name={},message={}", objectError.getObjectName(), objectError.getDefaultMessage());

}

}

return errors.toString();

}

@Data

@NoArgsConstructor

public class ErrorsModel {

@NotNull(message = "id must not be null!")

private Integer id;

@NotEmpty(message = "errors name must not be empty!")

private String name;

}

调用接口控制台 Warn 日志如下:

name=errors,message=errors name must not be empty!

一般情况下,不建议用这种方式处理 JSR 校验异常的属性项,因为会涉及到大量的重复的硬编码工作,建议直接继承 ResponseEntityExceptionHandler,覆盖对应的方法。

控制器方法的参数可以是 @value 注解修饰的参数,会从 Environment 中装配和转换属性值到对应的参数中 (也就是参数的来源并不是请求体),参数处理器为 ExpressionValueMethodArgumentResolver。举个例子:

@GetMapping(value = "/value")

public String value(@Value(value = "${spring.application.name}") String name) {

log.info("spring.application.name={}", name);

return name;

}

Map 类型参数的范围相对比较广,对应一系列的参数处理器,注意区别使用了上面提到的部分注解的 Map 类型和完全不使用注解的 Map 类型参数,两者的处理方式不相同。下面列举几个相对典型的 Map 类型参数处理例子。

不使用任何注解的 Map<String,Object> 参数

这种情况下参数实际上直接回调 ModelAndViewContainer 中的 ModelMap 实例,参数处理器为 MapMethodProcessor,往 Map 参数中添加的属性将会带到页面中。

使用 @RequestParam 注解的 Map<String,Object> 参数

这种情况下的参数处理器为 RequestParamMapMethodArgumentResolver,使用的请求方式需要指定 ContentType 为 x-www-form-urlencoded,不能使用 application/json 的方式:

spmvc-p-10

控制器代码为:

@PostMapping(value = "/map")

public String mapArgs(@RequestParam Map<String, Object> map) {

log.info("{}", map);

return map.toString();

}

使用 @RequestHeader 注解的 Map<String,Object> 参数

这种情况下的参数处理器为 RequestHeaderMapMethodArgumentResolver,作用是获取请求的所有请求头的 Key-Value。

使用 @PathVariable 注解的 Map<String,Object> 参数

这种情况下的参数处理器为 PathVariableMapMethodArgumentResolver,作用是获取所有路径参数封装为 Key-Value 结构。

批量文件上传的时候,我们一般需要接收一个 MultipartFile 集合,可以有两种选择:

getFiles 方法获取 MultipartFile 列表。spmvc-p-11

控制器方法代码如下:

@PostMapping(value = "/parts")

public String partArgs(@RequestParam(name = "file") List<MultipartFile> parts) {

log.info("{}", parts);

return parts.toString();

}

日期处理个人认为是请求参数处理中最复杂的,因为一般日期处理的逻辑不是通用的,过多的定制化处理导致很难有一个统一的标准处理逻辑去处理和转换日期类型的参数。不过,这里介绍几个通用的方法,以应对各种奇葩的日期格式。下面介绍的例子中全部使用 Jdk8 中引入的日期时间 API,围绕 java.util.Date 为核心的日期时间 API 的使用方式类同。

这种是最原始但是最奏效的方式,统一以字符串形式接收,然后自行处理类型转换,下面给个小例子:

@PostMapping(value = "/date1")

public String date1(@RequestBody UserDto userDto) {

UserEntity userEntity = new UserEntity();

userEntity.setUserId(userDto.getUserId());

userEntity.setBirthdayTime(LocalDateTime.parse(userDto.getBirthdayTime(), FORMATTER));

userEntity.setGraduationTime(LocalDateTime.parse(userDto.getGraduationTime(), FORMATTER));

log.info(userEntity.toString());

return "success";

}

@Data

public class UserDto {

private String userId;

private String birthdayTime;

private String graduationTime;

}

@Data

public class UserEntity {

private String userId;

private LocalDateTime birthdayTime;

private LocalDateTime graduationTime;

}

spmvc-p-12

@DateTimeFormat 注解配合 @RequestBody 的参数使用的时候,会发现抛出 InvalidFormatException 异常,提示转换失败,这是因为在处理此注解的时候,只支持 form 提交 (ContentType 为 x-www-form-urlencoded),例子如下:

spmvc-p-13

@Data

public class UserDto2 {

private String userId;

@DateTimeFormat(pattern = "yyyy-MM-dd HH:mm:ss")

private LocalDateTime birthdayTime;

@DateTimeFormat(pattern = "yyyy-MM-dd HH:mm:ss")

private LocalDateTime graduationTime;

}

@PostMapping(value = "/date2")

public String date2(UserDto2 userDto2) {

log.info(userDto2.toString());

return "success";

}

@PostMapping(value = "/date2")

public String date2(@RequestParam("name"="userId")String userId,

@RequestParam("name"="birthdayTime")LocalDateTime birthdayTime,

@RequestParam("name"="graduationTime")LocalDateTime graduationTime) {

return "success";

}

而 @jsonformat 注解可使用在 form 或者 Json 请求参数的场景,因此更推荐使用 @jsonformat 注解,不过注意需要指定时区 (timezone 属性,例如在**是东八区 "GMT+8"),否则有可能导致出现 "时差",举个例子:

@PostMapping(value = "/date2")

public String date2(@RequestBody UserDto2 userDto2) {

log.info(userDto2.toString());

return "success";

}

@Data

public class UserDto2 {

private String userId;

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime birthdayTime;

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime graduationTime;

}

因为 SpringMVC 默认使用 Jackson 处理 @RequestBody 的参数转换,因此可以通过定制序列化器和反序列化器来实现日期类型的转换,这样我们就可以使用 application/json 的形式提交请求参数。这里的例子是转换请求 Json 参数中的字符串为 LocalDateTime 类型,属于 Json 反序列化,因此需要定制反序列化器:

@PostMapping(value = "/date3")

public String date3(@RequestBody UserDto3 userDto3) {

log.info(userDto3.toString());

return "success";

}

@Data

public class UserDto3 {

private String userId;

@JsonDeserialize(using = CustomLocalDateTimeDeserializer.class)

private LocalDateTime birthdayTime;

@JsonDeserialize(using = CustomLocalDateTimeDeserializer.class)

private LocalDateTime graduationTime;

}

public class CustomLocalDateTimeDeserializer extends LocalDateTimeDeserializer {

public CustomLocalDateTimeDeserializer() {

super(DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss"));

}

}

前面三种方式都存在硬编码等问题,其实最佳实践是直接修改 MappingJackson2HttpMessageConverter 中的 ObjectMapper 对于日期类型处理默认的序列化器和反序列化器,这样就能全局生效,不需要再使用其他注解或者定制序列化方案 (当然,有些时候需要特殊处理定制),或者说,在需要特殊处理的场景才使用其他注解或者定制序列化方案。使用钩子接口 Jackson2ObjectMapperBuilderCustomizer 可以实现 ObjectMapper 的属性定制:

@Bean

public Jackson2ObjectMapperBuilderCustomizer jackson2ObjectMapperBuilderCustomizer(){

return customizer->{

customizer.serializerByType(LocalDateTime.class,new LocalDateTimeSerializer(

DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss")));

customizer.deserializerByType(LocalDateTime.class,new LocalDateTimeDeserializer(

DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss")));

};

}

这样就能定制化 MappingJackson2HttpMessageConverter 中持有的 ObjectMapper,上面的 LocalDateTime 序列化和反序列化器对全局生效。

前面基本介绍完了主流的请求参数处理,其实 SpringMVC 中还会按照 URL 的模式进行匹配,使用的是 Ant 路径风格,处理工具类为 org.springframework.util.AntPathMatcher,从此类的注释来看,匹配规则主要包括下面四点:

? 匹配 1 个字符。* 匹配 0 个或者多个字符。** 匹配路径中 0 个或者多个目录。{spring:[a-z]+} 将正则表达式 [a-z]+ 匹配到的值,赋值给名为 spring 的路径变量。举些例子:

? 形式的 URL:

@GetMapping(value = "/pattern?")

public String pattern() {

return "success";

}

/pattern 404 Not Found

/patternd 200 OK

/patterndd 404 Not Found

/pattern/ 404 Not Found

/patternd/s 404 Not Found

* 形式的 URL:

@GetMapping(value = "/pattern*")

public String pattern() {

return "success";

}

/pattern 200 OK

/pattern/ 200 OK

/patternd 200 OK

/pattern/a 404 Not Found

** 形式的 URL:

@GetMapping(value = "/pattern/**/p")

public String pattern() {

return "success";

}

/pattern/p 200 OK

/pattern/x/p 200 OK

/pattern/x/y/p 200 OK

{spring:[a-z]+} 形式的 URL:

@GetMapping(value = "/pattern/{key:[a-c]+}")

public String pattern(@PathVariable(name = "key") String key) {

return "success";

}

/pattern/a 200 OK

/pattern/ab 200 OK

/pattern/abc 200 OK

/pattern 404 Not Found

/pattern/abcd 404 Not Found

上面的四种 URL 模式可以组合使用,千变万化。

URL 匹配还遵循精确匹配原则,也就是存在两个模式对同一个 URL 都能够匹配成功,则选取最精确的 URL 匹配,进入对应的控制器方法,举个例子:

@GetMapping(value = "/pattern/**/p")

public String pattern1() {

return "success";

}

@GetMapping(value = "/pattern/p")

public String pattern2() {

return "success";

}

上面两个控制器,如果请求 URL 为 /pattern/p,最终进入的方法为 pattern2。

最后,org.springframework.util.AntPathMatcher 作为一个工具类,可以单独使用,不仅仅可以用于匹配 URL,也可以用于匹配系统文件路径,不过需要使用其带参数构造改变内部的 pathSeparator 变量,例如:

AntPathMatcher antPathMatcher = new AntPathMatcher(File.separator);

笔者在前一段时间曾经花大量时间梳理和分析过 Spring、SpringMVC 的源码,但是后面一段很长的时间需要进行业务开发,对架构方面的东西有点生疏了,毕竟东西不用就会生疏,这个是常理。这篇文章基于一些 SpringMVC 的源码经验总结了请求参数的处理相关的一些知识,希望帮到自己和大家。

参考资料:

(本文完)

更多精彩内容,就在简书 APP

"如果觉得我的文章对您有用,请随意打赏。你的支持和鼓励是我前进动力的一部分"

还没有人赞赏,支持一下

总资产 10 共写了 5.2W 字获得 223 个赞共 178 个粉丝

Spring Web MVC Spring Web MVC 是包含在 Spring 框架中的 Web 框架,建立于...

Spring Cloud 为开发人员提供了快速构建分布式系统中一些常见模式的工具(例如配置管理,服务发现,断路器,智...

首先, Promise 并不是发源于 javascript, 它最早被提出于 E 语言中. 那到底什么是 Promise, 它是抽...

最近看大陆鬼片类电影很难看到真正的 “鬼片”,结尾大多是主角因为有精神分裂症、被害妄想症等产生的“鬼” 的幻觉。整部剧...

林原雪狐阅读 895 评论 0 赞 0

https://www.jianshu.com/p/5f6abd08ee08

本文属于《算法图解》系列。学习动态规划,这是一种解决棘手问题的方法,它将问题分成小问题,并先着手解决这些小问题。

背包问题,在可装物品有限的前提下,尽量装价值最大的物品,如果物品数量足够大,简单的暴力穷举法是不可行的 O(2ⁿ), 前一章介绍了《贪婪算法》就是解决如何找到近似解,这接近最优解,但可能不是最优解。如何找到最优解呢?就是动态规划算法。动态规划先解决子问题,再逐步解决大问题。

每个动态规划算法都从一个网格开始,背包问题的网格如下。

网格的各行为商品,各列为不同容量(1~4 磅)的背包。所有这些列你都需要,因为它们将帮助你计算子背包的价值。网格最初是空的。你将填充其中的每个单元格,网格填满后,就找到了问题的答案。

1 吉他行

这是第一行,只有吉他可供你选择。第一个单元格表示背包的容量为 1 磅。吉他的重量也是 1 磅,这意味着它能装入背包!因此这个单元格包含吉他,价值为 1500 美元。来看下一个单元格。这个单元格表示背包的容量为 2 磅,完全能够装下吉他!以此类推。

你知道这不是最终的解。随着算法往下执行,你将逐步修改最大价值。

2 音响行

可选的有吉他和音响。在每一行, 可选的商品都为当前行的商品以及之前各行的商品。

背包的容量为 1 磅,能装下音响吗?音响太重了,装不下!由于容量 1 磅的背包装不下音响, 因此最大价值依然是 1500 美元。接下来的两个单元格的情况与此相同,背包容量为 4 磅呢?终于能够装下音响了!

3 笔记本电脑行

下面以同样的方式处理笔记本电脑。笔记本电脑重 3 磅,没法将其装入容量为 1 磅或 2 磅的背 包,因此前两个单元格的最大价值还是 1500 美元。对于容量为 3 磅的背包,可选笔记本电脑而不是吉他,这样新的最大价值将为 2000 美元!

对于容量为 4 磅的背包,情况很有趣。这是非常重要的部分。当前的最大价值为 3000 美元,选择笔记本电脑 2000 美元,还有 1 磅空间没用使用。根据之前计算的最大价值可知,在 1 磅的容量中可装入吉他,价值 1500 美元。因此,你需要做如下比较。

为何计算小背包可装入的商品的最大价值呢?因为余下了空间时,你可根据这些子问题的答案来确定余下的空间可装入哪些商品。笔记本电脑和吉他的总价值为 3500 美元,最终的网格类似于下面这样。

你可能认为,计算最后一个单元格的价值时,我使用了不同的公式。那是因为填充之前的单元格时,我故意避开了一些复杂的因素。其实,计算每个单元格的价值时,使用的公式都相同。 这个公式如下。

你可以使用这个公式来计算每个单元格的价值,最终的网格将与前一个网格相同。现在你明 白了为何要求解子问题吧?你可以合并两个子问题的解来得到更大问题的解。

假设你还选择一件商品:iPhone

此时需要重新执行前面所做的计算吗?不需要。别忘了,动态规划 逐步计算最大价值。

沿着一列往下走时,最大价值有可能降低吗?

答案:不可能。每次迭代时,你都存储当前的最大价值。最大价值不可能比以前低!

练习:假设你还可以选择 ——MP3 播放器,它重 1 磅,价值 1000 美元。你会选择吗?

不会。

假设你按如下顺序填充各行:音响、笔记本电脑、吉他。网格将会是什么样的?请自己动手填充这个网格,再接着往下读。

答案没有变化。也就是说,各行的排列顺序无关紧要。

自己动手试试吧!

这里推荐一个网站:http://karaffeltut.com/NEWKaraffeltutCom/Knapsack/knapsack.html

需要重新调整网格,计算的单位更新如(0.5)。可以自己动手验证下。

如果想这种情况下。只装商品的一部分。如何使用动态规划来处 理这种情形呢?

答案是没法处理。使用动态规划时,要么考虑拿走整件商品,要么考虑不拿,而没法判断该不该拿走商品的一部分。

但使用贪婪算法可轻松地处理这种情况!首先,尽可能多地拿价值最高的商品;如果拿光了, 再尽可能多地拿价值次高的商品,以此类推。

假设你要去伦敦度假,假期两天,但你想去游览的地方很多。你没法前往每个地方游览,因此你列个单子。

这也是一个背包问题!但约束条件不是背包的容量,而是有限的时间;不是决定该装入哪些 商品,而是决定该去游览哪些名胜。请根据这个清单绘制动态规划网格。

当我在纸上画这个网格,逐个元素去填值计算的时候,边上的土豪 QA 妹子,应该不应这么纠结,多待两天都逛完了。可见钱能解决 90% 的问题。

假设你还想去巴黎,因此在前述清单中又添加了几项。

去这些地方游览需要很长时间,因为你先得从伦敦前往巴黎,这需要半天时间。如果这 3 个地方都去玩,是不是要 4.5 天呢?

不是的,因为不是去每个地方都得先从伦敦到巴黎。到达巴黎后,每个地方都只需 1 天时间。

因此玩这 3 个地方需要的总时间为 3.5 天(半天从伦敦到巴黎,每个地方 1 天),而不是 4.5 天。

将埃菲尔铁塔加入 “背包” 后,卢浮宫将更 “便宜”:只要 1 天时间,而不是 1.5 天。如何使 用动态规划对这种情况建模呢?

没办法建模。动态规划功能强大,它能够解决子问题并使用这些答案来解决大问题。但仅当 每个子问题都是离散的,即不依赖于其他子问题时,动态规划才管用。

但根据动态规划算法的设计,最多只需合并两个子背包,即根本不会涉及两个以上的子背包。不过这些子背包可能又包含子背包。

完全可能,假设你选了一个 3.5 磅的钻石。

练习:

假设你要去野营。你有一个容量为 6 磅的背包,需要决定该携带下面的哪些东西。其中每样东西都有相应的价值,价值越大意味着越重要:

我推导的结果:水 + 食物 + 相机 = 25

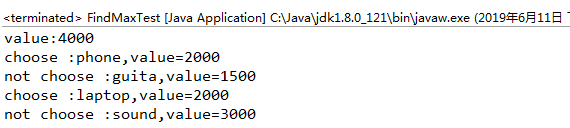

最后附上一版本 Java 解决背包问题。

public class FindMaxTest {static String[] names= {"","sound","laptop","guita","phone"};static int[] w = {0,4, 3, 1,1 };static int[] v = {0,3000,2000,1500,2000}; static int[][] b = new int[5][5];public static void main(String[] args) {for (int i = 1; i <= 4; i++) {for (int j = 1; j <= 4; j++) {int value1 = v[i] + b[i - 1][j - w[i]] ; int value2 = b[i - 1][j]; b[i][j] = Math.max(value1, value2); System.out.println("value:"+b[4][4]);public static void findMax(int i,int j){ System.out.println("not choose :"+names[i]+",value="+v[i]);else if( b[i][j]==(v[i] + b[i - 1][j - w[i]]) ){ System.out.println("choose :"+names[i]+",value="+v[i]);```

运行结果:

背包问题已经解决,利用动态规划解决此问题的效率即是填写此张表的效率,所以动态规划的时间效率为 O (number\*capacity)=O (n\*c),由于用到二维数组存储子问题的解,所以动态规划的空间效率为 O (n\*c)。

注意下一些代码细节,例子画的网格图是为了便于理解,实际 demo Java 取的数组是从 0 开始的。所以数组的比图上的网格多加了一行,一列的 0 的数组,无实际意义,纯粹为了填空格使用。还有网上有优化算法,二维数组转一维数组,只为了求值优化,但是不能找到最优组合选择的元素。感兴趣的可以试验下。

[https://blog.csdn.net/bohu83/article/details/91453227](https://blog.csdn.net/bohu83/article/details/91453227)

0.1892019.03.06 00:07:12 字数 2,917 阅读 11,150

代理模式:代理模式又叫委托模式,是为某个对象提供一个代理对象,并且由代理对象控制对原对象的访问。代理模式通俗来讲就是我们生活中常见的中介。

代理模式可以提供非常好的访问控制,应用比较广泛。

举个例子来说明:假如说我现在想买一辆二手车,虽然我可以自己去找车源,做质量检测等一系列的车辆过户流程,但是这确实太浪费我得时间和精力了。我只是想买一辆车而已为什么我还要额外做这么多事呢?于是我就通过中介公司来买车,他们来给我找车源,帮我办理车辆过户流程,我只是负责选择自己喜欢的车,然后付钱就可以了。

代理模式的通用类图:

代理模式的通用类图

一个代理类可以代理多个被委托者或被代理者,因此一个代理类具体代理哪个具体主题角色,是由场景类决定的。最简单的情况是一个主题类和一个代理类。通常情况下,一个接口只需要一个代理类,具体代理哪个实现类有高层模块决定。

代理类主要负责为委托类预处理消息、过滤消息、把消息转发给委托类,以及事后对返回结果的处理等。代理类本身并不真正实现服务,而是通过调用委托类的相关方法,来提供特定的服务。真正的业务功能还是由委托类来实现,但是可以在业务功能执行的前后加入一些公共的服务。例如我们想给项目加入缓存、日志这些功能,我们就可以使用代理类来完成,而没必要打开已经封装好的委托类。

为了保持行为的一致性,代理类和委托类通常会实现相同的接口,所以在访问者看来两者没有丝毫的区别。通过代理类这中间一层,能有效控制对委托类对象的直接访问,也可以很好地隐藏和保护委托类对象,同时也为实施不同控制策略预留了空间,从而在设计上获得了更大的灵活性。

更通俗的说,代理解决的问题是:当两个类需要通信时,引入第三方代理类,将两个类的关系解耦,让我们只了解代理类即可,而且代理的出现还可以让我们完成与另一个类之间的关系的统一管理。但是切记,代理类和委托类要实现相同的接口,因为代理真正调用的还是委托类的方法。

代理模式有多种不同的实现方式。如果按照代理创建的时期来进行分类:静态代理、动态代理。

抽象主题类

public interface Subject {

public void request();

}

具体主题类

public class ConcreteSubject implements Subject {

@Override

public void request() {

}

}

代理类

public class Proxy implements Subject {

private Subject subject = null;

public Proxy() {

this.subject = new Proxy();

}

public Proxy(Subject subject) {

this.subject = subject;

}

public Proxy(Object... objects) {

}

@Override

public void request() {

this.before();

this.subject.request();

this.after();

}

private void before() {

}

private void after() {

}

}

客户端类

public class Client {

public static void main(String[] args) {

Subject subject = new ConcreteSubject();

Proxy proxy = new Proxy(subject);

proxy.request();

}

}

静态代理优缺点

Subject subject = new ConcreteSubject(); Proxy proxy = new Proxy(subject); 可以应用工厂方法将它隐藏。从静态代理会发现 —— 每个代理类只能为一个接口服务,这样程序开发中必然会产生许多的代理类。所以我们想办法通过一个代理类完成全部的代理功能,那么我们就需要用动态代理.

在上面 4.1 的示例中,一个代理只能代理一种类型,而且是在编译器就已经确定被代理的对象。而动态代理是在运行时,通过反射机制实现动态代理,并且能够代理各种类型的对象。

在 Java 中要想实现动态代理机制,需要 java.lang.reflect.InvocationHandler 接口和 java.lang.reflect.Proxy 类的支持。

java.lang.reflect.InvocationHandler 接口的定义

package java.lang.reflect;

public interface InvocationHandler {

public Object invoke(Object proxy, Method method, Object[] args)

throws Throwable;

}

参数解释:

java.lang.reflect.Proxy 类的定义

public class Proxy implements java.io.Serializable {

private static final long serialVersionUID = -2222568056686623797L;

private static final Class<?>[] constructorParams =

{ InvocationHandler.class };

private static final WeakCache<ClassLoader, Class<?>[], Class<?>>

proxyClassCache = new WeakCache<>(new KeyFactory(), new ProxyClassFactory());

protected InvocationHandler h;

private Proxy() {

}

protected Proxy(InvocationHandler h) {

Objects.requireNonNull(h);

this.h = h;

}

@CallerSensitive

public static Class<?> getProxyClass(ClassLoader loader,

Class<?>... interfaces)

throws IllegalArgumentException

{

final Class<?>[] intfs = interfaces.clone();

final SecurityManager sm = System.getSecurityManager();

if (sm != null) {

checkProxyAccess(Reflection.getCallerClass(), loader, intfs);

}

return getProxyClass0(loader, intfs);

}

private static void checkProxyAccess(Class<?> caller,

ClassLoader loader,

Class<?>... interfaces)

{

SecurityManager sm = System.getSecurityManager();

if (sm != null) {

ClassLoader ccl = caller.getClassLoader();

if (VM.isSystemDomainLoader(loader) && !VM.isSystemDomainLoader(ccl)) {

sm.checkPermission(SecurityConstants.GET_CLASSLOADER_PERMISSION);

}

ReflectUtil.checkProxyPackageAccess(ccl, interfaces);

}

}

private static Class<?> getProxyClass0(ClassLoader loader,

Class<?>... interfaces) {

if (interfaces.length > 65535) {

throw new IllegalArgumentException("interface limit exceeded");

}

return proxyClassCache.get(loader, interfaces);

}

private static final Object key0 = new Object();

private static final class Key1 extends WeakReference<Class<?>> {

private final int hash;

Key1(Class<?> intf) {

super(intf);

this.hash = intf.hashCode();

}

@Override

public int hashCode() {

return hash;

}

@Override

public boolean equals(Object obj) {

Class<?> intf;

return this == obj ||

obj != null &&

obj.getClass() == Key1.class &&

(intf = get()) != null &&

intf == ((Key1) obj).get();

}

}

private static final class Key2 extends WeakReference<Class<?>> {

private final int hash;

private final WeakReference<Class<?>> ref2;

Key2(Class<?> intf1, Class<?> intf2) {

super(intf1);

hash = 31 * intf1.hashCode() + intf2.hashCode();

ref2 = new WeakReference<Class<?>>(intf2);

}

@Override

public int hashCode() {

return hash;

}

@Override

public boolean equals(Object obj) {

Class<?> intf1, intf2;

return this == obj ||

obj != null &&

obj.getClass() == Key2.class &&

(intf1 = get()) != null &&

intf1 == ((Key2) obj).get() &&

(intf2 = ref2.get()) != null &&

intf2 == ((Key2) obj).ref2.get();

}

}

private static final class KeyX {

private final int hash;

private final WeakReference<Class<?>>[] refs;

@SuppressWarnings("unchecked")

KeyX(Class<?>[] interfaces) {

hash = Arrays.hashCode(interfaces);

refs = (WeakReference<Class<?>>[])new WeakReference<?>[interfaces.length];

for (int i = 0; i < interfaces.length; i++) {

refs[i] = new WeakReference<>(interfaces[i]);

}

}

@Override

public int hashCode() {

return hash;

}

@Override

public boolean equals(Object obj) {

return this == obj ||

obj != null &&

obj.getClass() == KeyX.class &&

equals(refs, ((KeyX) obj).refs);

}

private static boolean equals(WeakReference<Class<?>>[] refs1,

WeakReference<Class<?>>[] refs2) {

if (refs1.length != refs2.length) {

return false;

}

for (int i = 0; i < refs1.length; i++) {

Class<?> intf = refs1[i].get();

if (intf == null || intf != refs2[i].get()) {

return false;

}

}

return true;

}

}

private static final class KeyFactory

implements BiFunction<ClassLoader, Class<?>[], Object>

{

@Override

public Object apply(ClassLoader classLoader, Class<?>[] interfaces) {

switch (interfaces.length) {

case 1: return new Key1(interfaces[0]);

case 2: return new Key2(interfaces[0], interfaces[1]);

case 0: return key0;

default: return new KeyX(interfaces);

}

}

}

private static final class ProxyClassFactory

implements BiFunction<ClassLoader, Class<?>[], Class<?>>

{

private static final String proxyClassNamePrefix = "$Proxy";

private static final AtomicLong nextUniqueNumber = new AtomicLong();

@Override

public Class<?> apply(ClassLoader loader, Class<?>[] interfaces) {

Map<Class<?>, Boolean> interfaceSet = new IdentityHashMap<>(interfaces.length);

for (Class<?> intf : interfaces) {

Class<?> interfaceClass = null;

try {

interfaceClass = Class.forName(intf.getName(), false, loader);

} catch (ClassNotFoundException e) {

}

if (interfaceClass != intf) {

throw new IllegalArgumentException(

intf + " is not visible from class loader");

}

if (!interfaceClass.isInterface()) {

throw new IllegalArgumentException(

interfaceClass.getName() + " is not an interface");

}

if (interfaceSet.put(interfaceClass, Boolean.TRUE) != null) {

throw new IllegalArgumentException(

"repeated interface: " + interfaceClass.getName());

}

}

String proxyPkg = null;

int accessFlags = Modifier.PUBLIC | Modifier.FINAL;

for (Class<?> intf : interfaces) {

int flags = intf.getModifiers();

if (!Modifier.isPublic(flags)) {

accessFlags = Modifier.FINAL;

String name = intf.getName();

int n = name.lastIndexOf('.');

String pkg = ((n == -1) ? "" : name.substring(0, n + 1));

if (proxyPkg == null) {

proxyPkg = pkg;

} else if (!pkg.equals(proxyPkg)) {

throw new IllegalArgumentException(

"non-public interfaces from different packages");

}

}

}

if (proxyPkg == null) {

proxyPkg = ReflectUtil.PROXY_PACKAGE + ".";

}

long num = nextUniqueNumber.getAndIncrement();

String proxyName = proxyPkg + proxyClassNamePrefix + num;

byte[] proxyClassFile = ProxyGenerator.generateProxyClass(

proxyName, interfaces, accessFlags);

try {

return defineClass0(loader, proxyName,

proxyClassFile, 0, proxyClassFile.length);

} catch (ClassFormatError e) {

throw new IllegalArgumentException(e.toString());

}

}

}

@CallerSensitive

public static Object newProxyInstance(ClassLoader loader,

Class<?>[] interfaces,

InvocationHandler h)

throws IllegalArgumentException

{

Objects.requireNonNull(h);

final Class<?>[] intfs = interfaces.clone();

final SecurityManager sm = System.getSecurityManager();

if (sm != null) {

checkProxyAccess(Reflection.getCallerClass(), loader, intfs);

}

Class<?> cl = getProxyClass0(loader, intfs);

try {

if (sm != null) {

checkNewProxyPermission(Reflection.getCallerClass(), cl);

}

final Constructor<?> cons = cl.getConstructor(constructorParams);

final InvocationHandler ih = h;

if (!Modifier.isPublic(cl.getModifiers())) {

AccessController.doPrivileged(new PrivilegedAction<Void>() {

public Void run() {

cons.setAccessible(true);

return null;

}

});

}

return cons.newInstance(new Object[]{h});

} catch (IllegalAccessException|InstantiationException e) {

throw new InternalError(e.toString(), e);

} catch (InvocationTargetException e) {

Throwable t = e.getCause();

if (t instanceof RuntimeException) {

throw (RuntimeException) t;

} else {

throw new InternalError(t.toString(), t);

}

} catch (NoSuchMethodException e) {

throw new InternalError(e.toString(), e);

}

}

private static void checkNewProxyPermission(Class<?> caller, Class<?> proxyClass) {

SecurityManager sm = System.getSecurityManager();

if (sm != null) {

if (ReflectUtil.isNonPublicProxyClass(proxyClass)) {

ClassLoader ccl = caller.getClassLoader();

ClassLoader pcl = proxyClass.getClassLoader();

int n = proxyClass.getName().lastIndexOf('.');

String pkg = (n == -1) ? "" : proxyClass.getName().substring(0, n);

n = caller.getName().lastIndexOf('.');

String callerPkg = (n == -1) ? "" : caller.getName().substring(0, n);

if (pcl != ccl || !pkg.equals(callerPkg)) {

sm.checkPermission(new ReflectPermission("newProxyInPackage." + pkg));

}

}

}

}

public static boolean isProxyClass(Class<?> cl) {

return Proxy.class.isAssignableFrom(cl) && proxyClassCache.containsValue(cl);

}

@CallerSensitive

public static InvocationHandler getInvocationHandler(Object proxy)

throws IllegalArgumentException

{

if (!isProxyClass(proxy.getClass())) {

throw new IllegalArgumentException("not a proxy instance");

}

final Proxy p = (Proxy) proxy;

final InvocationHandler ih = p.h;

if (System.getSecurityManager() != null) {

Class<?> ihClass = ih.getClass();